🍵 Linear Regression 절대 초보자를 위한 차와 함께 — 제로 지식 비유

Source: Dev.to

머신러닝은 위협적으로 느껴질 수 있습니다 — 기울기, 비용 함수, 정규화, 과적합… 마치 외국어처럼 들리죠.

그러니 용어는 잠시 잊어버리세요.

당신이 차 가게를 운영한다고 상상해 보세요. 매일 다음을 기록합니다:

- 온도

- 판매된 차 잔 수

당신의 목표는? 👉 내일의 차 판매량을 예측하는 것.

이 하나의 목표만으로도 다음 모든 개념을 배울 수 있습니다:

- 선형 회귀

- 비용 함수

- 경사 하강법

- 과적합

- 정규화

- 정규화된 비용 함수

시작해 봅시다.

⭐ 시나리오 1: 선형 회귀란 무엇인가?

온도에 따른 차 판매 예측

당신은 다음을 관찰합니다:

| 온도 (°C) | 판매된 차 잔 수 |

|---|---|

| 10 | 100 |

| 15 | 80 |

| 25 | 40 |

패턴이 있습니다: 온도가 낮을수록 차를 더 많이 판매합니다.

선형 회귀는 이 관계를 가장 잘 나타내는 직선을 그리려고 합니다:

[ \hat{y}=mx+c ]

- (x) = 온도

- (\hat{y}) = 예측된 차 판매량

- (m) = 기울기 (온도가 1도 상승할 때 차 판매량이 얼마나 감소하는지)

- (c) = 기본 차 수요

그게 전부입니다 — 내일의 차 판매량을 예측하는 간단한 직선.

⭐ Scenario 2: Cost Function

Measuring “How Wrong” Your Predictions Are

Today’s temperature: 20 °C

Your model predicted: 60 cups

Actual: 50 cups

Error = 10 cups

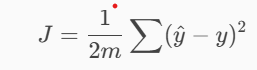

The cost function gives a score for your overall wrongness:

Why square?

Because being wrong by 30 cups is far worse than being wrong by 3 cups, and the model should learn that.

The lower the cost → the better the model.

⭐ 시나리오 3: Gradient Descent

단계별 개선의 예술

새로운 차 레시피를 실험한다고 상상해 보세요:

- 설탕을 더 넣으면 → 너무 달다

- 설탕을 덜 넣으면 → 너무 밍밍하다

- 완벽해질 때까지 천천히 조절한다

이것이 바로 Gradient Descent 입니다.

모델은 다음을 단계별로 조정합니다:

- 기울기 ((m))

- 절편 ((c))

비용 함수는 언덕이라고 생각하세요. 여러분은 그 위 어딘가에 서 있습니다. 목표는 가장 낮은 지점으로 내려가는 것입니다. 그 가장 낮은 지점이 바로 최적 모델입니다.

⭐ 시나리오 4: 과적합

모델이 너무 열심히 시도하고 “노이즈”를 학습할 때

매일 너무 많은 세부 사항을 기록한다고 가정해 보세요:

- 온도

- 습도

- 비

- 바람

- 축제

- 크리켓 경기 점수

- 교통

- 이웃집 개 짖는 소리

- 고객들의 셔츠 색상

- 하늘이 얼마나 흐린지

모델은 모든 것을 사용하려고 하며, 중요하지 않은 것들까지도 포함합니다.

이는 과적합을 초래합니다:

- 모델이 훈련 데이터에서 훌륭하게 작동합니다

- 그러나 새로운 데이터에서는 끔찍하게 작동합니다

일반적인 패턴을 이해하는 대신 기억해 버립니다.

⭐ 시나리오 5: 과적합을 어떻게 해결할까?

- ✔ 쓸모 없는 특징 제거 – “dog barking” 등과 같은 잡음을 무시합니다.

- ✔ 더 많은 데이터 수집 – 예시가 많아질수록 패턴이 명확해집니다.

- ✔ 정규화 적용 – 가장 강력한 해결책입니다.

⭐ Scenario 6: 정규화란 무엇인가?

모델이 과도하게 생각하는 것을 막기 위한 패널티 추가

당신의 차 가게에서 차를 만드는 사람이 재료를 너무 많이 사용하면 차가 다음과 같이 됩니다:

- 혼란스러운

- 강한

- 비싼

- 예측 불가능한

그래서 당신은 그에게 이렇게 말합니다:

“재료를 적게 써. 너무 많이 쓰면 보너스를 삭감할 거야.”

그 패널티는 그가 단순하고 일관된 차를 만들도록 강제합니다.

정규화도 머신러닝 모델에 똑같이 적용됩니다. 정규화는 이렇게 말합니다:

“모델이 너무 복잡해지면 비용을 늘릴게.”

이렇게 하면 모델은 중요한 특징만 남기도록 강제됩니다.

⭐ 시나리오 7: 정규화된 선형 회귀

(상세 설명 포함)

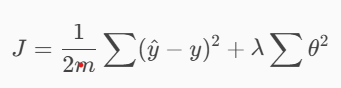

정규화는 일반적인 비용 함수에 다음과 같이 변형을 가합니다:

여기서:

- (\theta) = 모델 파라미터 (각 특징의 가중치)

- (\lambda) = 정규화 강도 (값이 클수록 더 강한 페널티)

🟦 이 페널티는 무엇을 하나요?

10개의 특징을 추적한다고 가정해 보세요:

- 온도

- 습도

- 바람

- 비

- 축제

- 요일

- 도로 교통량

- 크리켓 경기 점수

- 지역 소음 수준

- 개 짖는 소리 빈도

모델은 모두를 설명하려고 합니다. 일부 가중치는 크게 됩니다:

| 특징 | 가중치 |

|---|---|

| 온도 | 1.2 |

| 축제 | 2.8 |

| 교통량 | 3.1 |

| 개 짖는 소리 | 1.5 |

| 소음 수준 | 2.4 |

큰 가중치 = 모델이 해당 특징을 매우 중요하게 여기지만, 실제로는 무작위 잡음일 수도 있습니다.

정규화는 이러한 가중치를 줄이는 페널티를 추가합니다:

- 온도 → 중요도 유지

- 축제 → 약간 감소

- 개 짖는 소리 → 0에 가깝게 축소

- 소음 → 0에 가깝게 축소

이렇게 하면 모델이 더 간단하고, 일반화가 잘 되며, 정확도도 향상됩니다.

⭐ 시나리오 8: 정규화가 과적합을 해결하는 방법

(깊은 실제 시나리오)

정규화 전: 과도하게 생각하는 모델

모델이 모든 무작위 세부 사항을 눈에 띄게 인식합니다:

어느 날 비가 왔고 인도가 경기를 이겼으며 축제가 열리고 날씨가 추웠고 교통량이 적었어요… 그날 차 판매량이 높았습니다.

그래서 모델은 다음과 같이 생각합니다:

- “비가 차 판매량을 6 % 증가시킨다”

- “크리켓 경기 결과가 판매량을 8 % 증가시킨다”

- “개 짖는 소리가 판매량을 2 % 감소시킨다”

- “교통량이 판매량을 4 % 증가시킨다”

- …등등.

이는 우연을 외우는 전형적인 과적합입니다.

정규화 후:

패널티가 모델이 실제로 예측에 도움이 되는 특징(예: 온도)만을 남기고, 잡음이 섞인 특징(개 짖음, 크리켓 점수 등)은 0에 가깝게 만들도록 강제합니다. 이렇게 만든 모델은 새로운 날에도 잘 일반화되어 보다 신뢰할 수 있는 판매 예측을 제공합니다.

정규화: 성숙한 모델

정규화는 쓸모없는 가중치를 축소합니다:

- 개 짖음 → 0

- 크리켓 경기 → 0

- 소음 → 0

- 교통 → 아주 작게

- 축제 → 보통

- 온도 → 강하게 유지

- 비 → 보통

모델이 학습합니다:

“매출은 주로 온도 + 비 + 축제일에 의존합니다. 그 외 모든 것은 잡음입니다.”

정규화가 도움이 되는 이유

- 무작위 세부 사항에 대한 의존도 감소

- 간단한 규칙 장려

- 미래 날짜에 대한 일반화 향상

이것이 정규화가 실제 머신러닝에서 필수적인 이유입니다.

🎯 최종 요약 (초보자에게 완벽)

| Concept | Meaning | Tea‑Stall Analogy |

|---|---|---|

| Linear Regression | 최적의 직선 피팅 | 온도로부터 차 판매량 예측 |

| Cost Function | 오류 정도를 측정 | 예측이 실제 차 판매량과 얼마나 차이 나는지 |

| Gradient Descent | 최적화 기법 | 차 레시피를 완벽해질 때까지 조정 |

| Overfitting | 모델이 잡음을 기억함 | 개 짖음과 크리켓 경기 추적 |

| Regularization | 복잡도에 대한 페널티 | 차 제조자가 재료를 적게 사용하도록 강제 |

| Regularized Cost | 일반 비용 + 페널티 | 예측을 “과도하게 생각”하는 것을 방지 |