2026 年的伟大 AI 融合:PyTorch vs. TensorFlow

Source: Dev.to

在快速演进的人工智能领域,两个巨头仍然主导着整个格局:PyTorch 和 TensorFlow。多年来,开发者一直在争论哪个框架更优秀,但随着 2025 年的推进,讨论的焦点已经转变。现在不再仅仅是 “哪个更好”,而是 “哪个更适合你的特定工作流”。

无论你是推动生成式 AI 前沿的研究者,还是将模型部署到数百万边缘设备的工程师,了解这些框架的细微差别都是必不可少的。

1. 核心哲学 – 灵活性 vs. 结构

| 方面 | PyTorch(动态图) | TensorFlow(静态/混合) |

|---|---|---|

| 来源 | 由 Meta 开发 | 由 Google 开发 |

| 计算图 | Define‑by‑run – 图在代码执行时即时构建。感觉像原生 Python;可以使用标准循环、条件语句和调试器(例如 pdb)。 | Define‑and‑run – 最初是执行前编译的静态图。TensorFlow 2.x 引入了 Eager Execution,提供类似 PyTorch 的灵活性,但核心仍是优化的静态编译。 |

| 优化重点 | 强调实验和调试的便利性。 | 强调激进的硬件层面优化(例如 XLA、TPU 支持)。 |

2. 开发者体验与调试

-

PyTorch

- 目前在流畅的 Developer Experience(DX)方面占据王冠。

- 与 Python 生态系统无缝集成;调试只需在训练循环中插入

print()语句或断点即可。 - 清晰的堆栈跟踪使定位问题变得容易。

-

TensorFlow

- 由于 Keras,其高级 API 能以“乐高积木”式堆叠层快速构建模型,差距已显著缩小。

- 当需要深入 under the hood(自定义损失函数、复杂梯度计算)时,错误信息仍可能比 PyTorch 的直观跟踪更晦涩。

3. 生产与部署 – 企业级边缘

| Feature | PyTorch | TensorFlow |

|---|---|---|

| Enterprise‑grade tooling | TorchServe 用于服务,TorchScript 用于模型序列化,支持 ONNX 以实现互操作性。 | TensorFlow Extended (TFX) 用于端到端流水线,TensorFlow Lite 用于移动/物联网,TensorFlow Serving 用于可扩展的模型服务,支持版本管理和滚动更新。 |

| Maturity for large‑scale deployments | 快速提升;适用于众多生产场景。 | 历史悠久,在大规模全球基础设施中经受实战考验。 |

| Ecosystem “batteries‑included” | 生态系统正在增长,但仍在追赶 TensorFlow 的广度。 | 完整套件覆盖数据摄取、训练、验证、服务和监控。 |

4. Performance – 2025 Benchmarks

-

PyTorch 2.0+

- 引入了

torch.compile(),利用 Triton 编译器。 - 只需一行代码即可实现 30 %–60 % 的典型加速。

- 引入了

-

TensorFlow

- 使用 XLA(Accelerated Linear Algebra) 来融合操作并降低内存开销。

- 在 Google TPU 和高吞吐量推理工作负载上表现尤为高效。

总体观察:

- PyTorch 在原型开发和中小规模训练时略快。

- TensorFlow 在大规模、高吞吐量推理场景中往往更占优势。

TL;DR

- 如果你更看重快速实验、直观调试以及 Python‑优先的使用体验,选择 PyTorch。

- 如果你需要一个成熟、面向企业的生态系统,并且需要强大的工具链来支撑大规模生产,尤其是面向移动/IoT 或 TPU 硬件的部署,选择 TensorFlow。

两个框架在灵活性和性能方面已经高度趋同,因此现在的“正确”选择取决于你的工作流细节、团队专长以及部署目标。

End‑to‑End ML 生命周期工具

- TensorFlow Extended (TFX) – 用于管理端到端流水线的平台。

- TensorFlow Lite – 在移动端(iOS/Android)和物联网设备上部署模型的黄金标准。

- TensorFlow Serving – 成熟度极高的工具,用于大规模部署模型,内置版本管理和滚动更新。

PyTorch 通过 TorchServe、TorchScript 以及对 ONNX(开放神经网络交换)格式的支持取得了巨大的进展,弥合了差距。然而,对于需要在全球基础设施上部署成千上万模型的公司来说,TensorFlow 的成熟度仍然难以匹敌。

5. 性能:2025 年基准(重新审视)

- PyTorch 2.0+ 引入了

torch.compile(),使用 Triton 编译器提供巨大的加速(通常为 30 %–60 %),只需一行代码。 - TensorFlow 利用 XLA 融合操作并降低内存开销,在 Google 的 TPU 上表现尤为高效。

要点

- 对于原型开发和中小规模训练,PyTorch 稍快一些。

- 在大规模生产工作负载的高吞吐推理方面,TensorFlow 常常占优势。

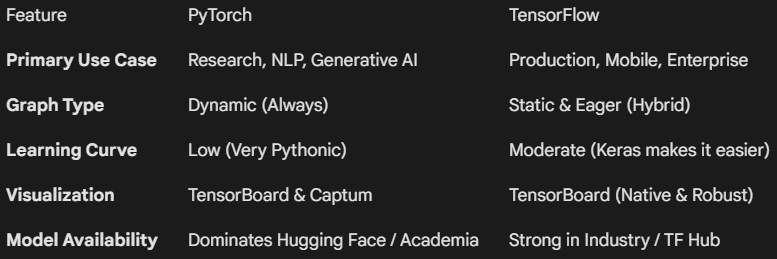

一目了然的比较

6. 生态系统与社区

- PyTorch – 学术界的宠儿。arXiv 上的新 AI 论文约有 90 % 使用 PyTorch,使其成为 GPT‑4 变体或 Stable Diffusion 等前沿模型的首选。

- TensorFlow – 拥有庞大的企业足迹。深度集成于 Google Cloud Platform(GCP),并受到零售、金融和医疗等大规模行业的青睐,这些行业更看重稳定性和长期支持,而非实验性功能。

最终结论:该选哪个?

“框架之争”已经进入和平僵局——两种工具都很优秀,只是服务的对象不同。

- 如果你是学生、研究员或初创公司的开发者,就选择 PyTorch; 你希望快速迭代、尝试自定义架构,并且能够使用 Hugging Face 上的最新开源模型。

- 如果你在大规模生产环境中工作,需要将模型部署到移动端/网页,或在 Google Cloud 生态系统中投入大量资源,就选择 TensorFlow。

小技巧

到 2026 年,最有价值的 AI 工程师是“双语”人才。由于底层概念(张量、反向传播、优化器)是相同的,掌握一个框架会让学习另一个框架变得更容易。