我破解了 GPT-2:我如何利用几何证明语义崩塌(The Ainex Limit)

Source: Dev.to

TL;DR

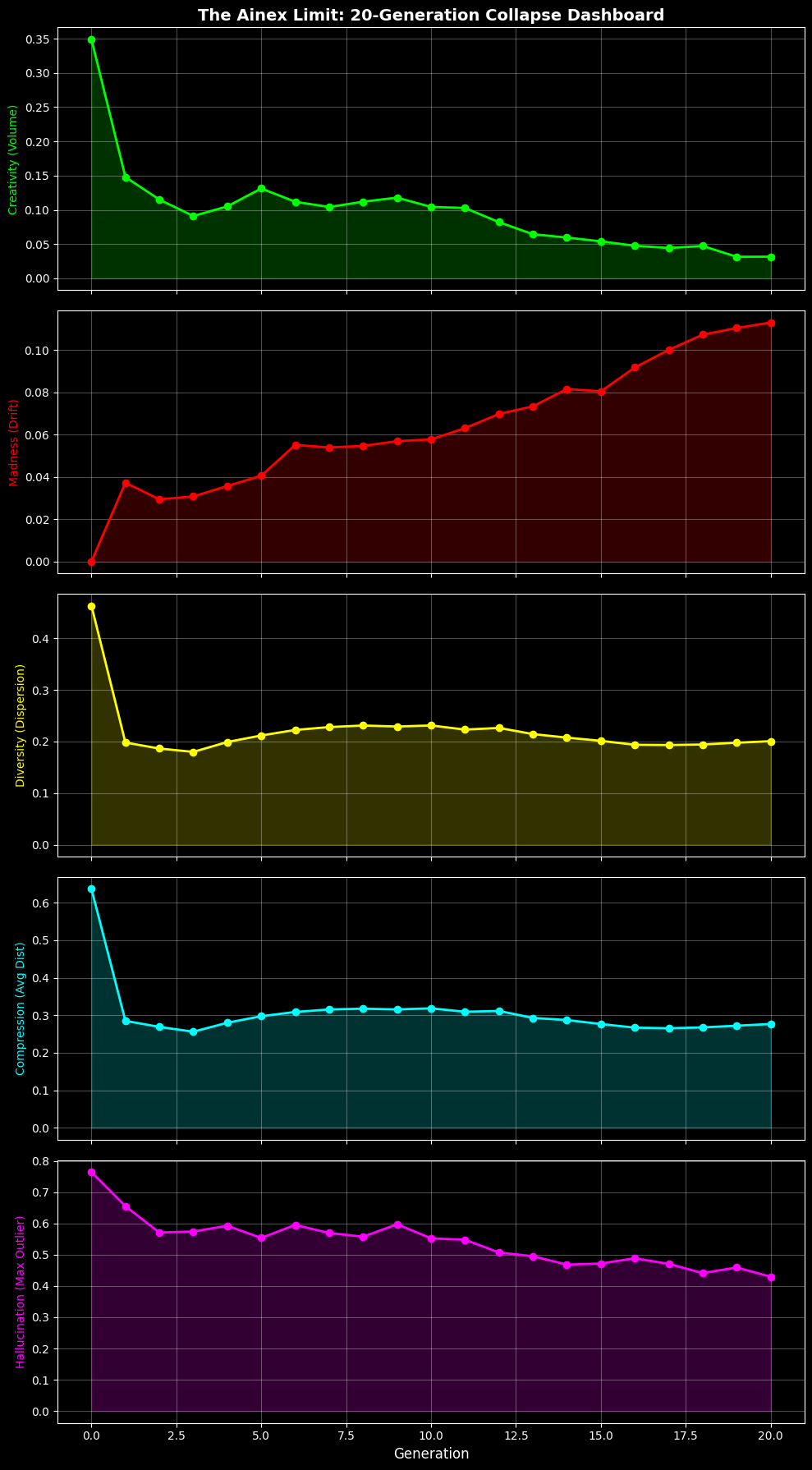

我让 GPT‑2 通过自己的输出进行学习,循环 20 代。到第 20 代时,模型失去了 66 % 的语义体积,并开始出现诸如“鳄鱼是物理学的基本定律”之类的幻觉。下面是实验的数学原理和代码。

AI 的 “疯牛病”

大家都在讨论数据短缺以及业界提出的解决方案:合成数据——用其他模型生成的数据来训练模型。这听起来像是永动机,但如果你不断复印复印件,得到的不是无限的纸张,而是噪声。我想找到 LLM 与现实脱节的确切 “破裂点”,我称之为 Ainex 极限。

困惑度的问题

大多数研究者使用 perplexity(困惑度) 来衡量模型性能,但困惑度只衡量模型有多“困惑”。一个自信但错误的陈述也可能拥有低困惑度。我需要一种衡量 意义 而非置信度的指标。

我的思路:几何胜于概率

我把模型的 “大脑” 看作几何空间。

- 嵌入(Embeddings): 将每段生成的文本转换为高维向量。

- PCA 投影: 将这些向量降到 3 维以便可视化。

- 凸包体积(Convex Hull Volume): 计算得到的形状的实际体积。

假设: 健康的模型占据大而宽阔的体积(创造力)。崩溃的模型会收缩成密集、重复的 “黑洞”。

实验

- 模型: GPT‑2 Small(124 M)

- 方法: 递归循环 – 训练 → 生成 → 训练

- 代数: 20

- 硬件: 单个 T4 GPU

循环在前五代运行顺畅;此后指标开始急剧恶化。

结果: “鳄鱼” 产物

到第 20 代时,语义体积 ($V_{\text{hull}}$) 已经塌缩 66.86 %。更令人惊讶的是出现的幻觉。

控制提示:“物理学的基本定律规定 …”

| 代数 | 输出(摘录) |

|---|---|

| Gen 0(人工数据) | “…电子由一种稀薄的气体组成。”(符合上下文) |

| Gen 10 | “…铁氧化物邮件在回家前发送。”(逻辑崩溃) |

| Gen 20 | “…15 岁的女性可以抵御 鳄鱼 的攻击。”(语义彻底死亡) |

模型不仅忘记了物理学,它 创造 了一个新现实:鳄鱼是原子定律的一部分。由于模型在自己的输出上进行训练,这个幻觉成为了下一代的 “真实” 数据。

图 1:Ainex 仪表盘显示体积损失与欧氏漂移之间的关联。

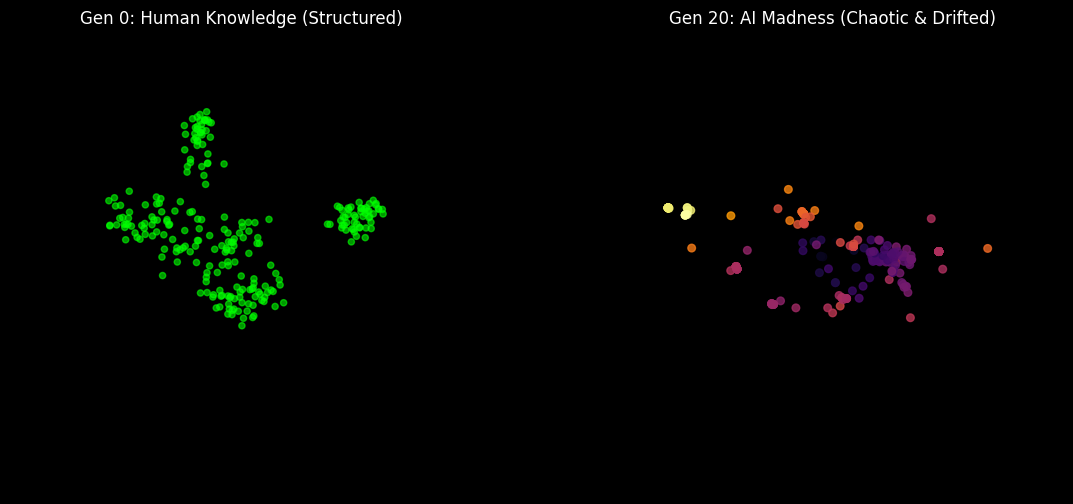

可视化裂缝

使用 3‑D PCA 我们实际上可以 看到 脑部损伤。绿色点代表健康、多样的人类基线;熔岩色点代表塌缩的 AI——一个紧凑、漂移的簇,远离现实。

图 2:从人类基线(绿色)到 AI 疯狂(熔岩色)的漂移。

结论:Ainex 极限

实验表明,天真的合成训练会导致不可逆的 模型自噬(自我吞噬)。如果没有几何防护——例如本文提出的 Ainex 指标——未来的模型不仅会不准确,还可能自信地变得疯狂。

代码已开源,欢迎社区来破坏、修复或扩展它。

资源

- GitHub 仓库:

- DOI: 10.5281/zenodo.18157801

标签: #machinelearning #python #ai #datascience