재귀 언어 모델이란 무엇인가?

Source: Dev.to

번역할 텍스트를 제공해 주시면 한국어로 번역해 드리겠습니다.

데이터 레이크하우스 도서 받기

- Apache Iceberg: The Definitive Guide

- Apache Polaris: The Definitive Guide

- Architecting an Apache Iceberg Lakehouse

- The Apache Iceberg Digest: Vol. 1

Lakehouse Community

- Data Lakehouse 커뮤니티에 참여하기

- Data Lakehouse 블로그 롤

- OSS 커뮤니티 목록

- Dremio Lakehouse 개발자 허브

Source:

Recursive Language Models (RLMs)

Recursive Language Models (RLMs)은 스스로를 호출하는 언어 모델입니다.

처음엔 이상하게 들릴 수 있지만 개념은 간단합니다: 질문에 한 번에 답하는 대신, RLM은 작업을 더 작은 부분으로 나누고 그 하위 질문들을 스스로에게 묻습니다. 구조화된 함수 호출을 사용하면서 단계별로 답을 구축합니다.

How RLMs differ from standard LLMs

일반적인 모델은 프롬프트로부터 전체 응답을 직접 예측하려고 합니다. 작업에 여러 단계가 포함돼 있으면, 모든 단계를 하나의 텍스트 흐름 안에서 관리해야 합니다. 짧은 작업에는 괜찮을 수 있지만, 모델이 중간 결과를 기억하거나 동일한 논리를 여러 번 재사용해야 할 때는 금방 무너집니다.

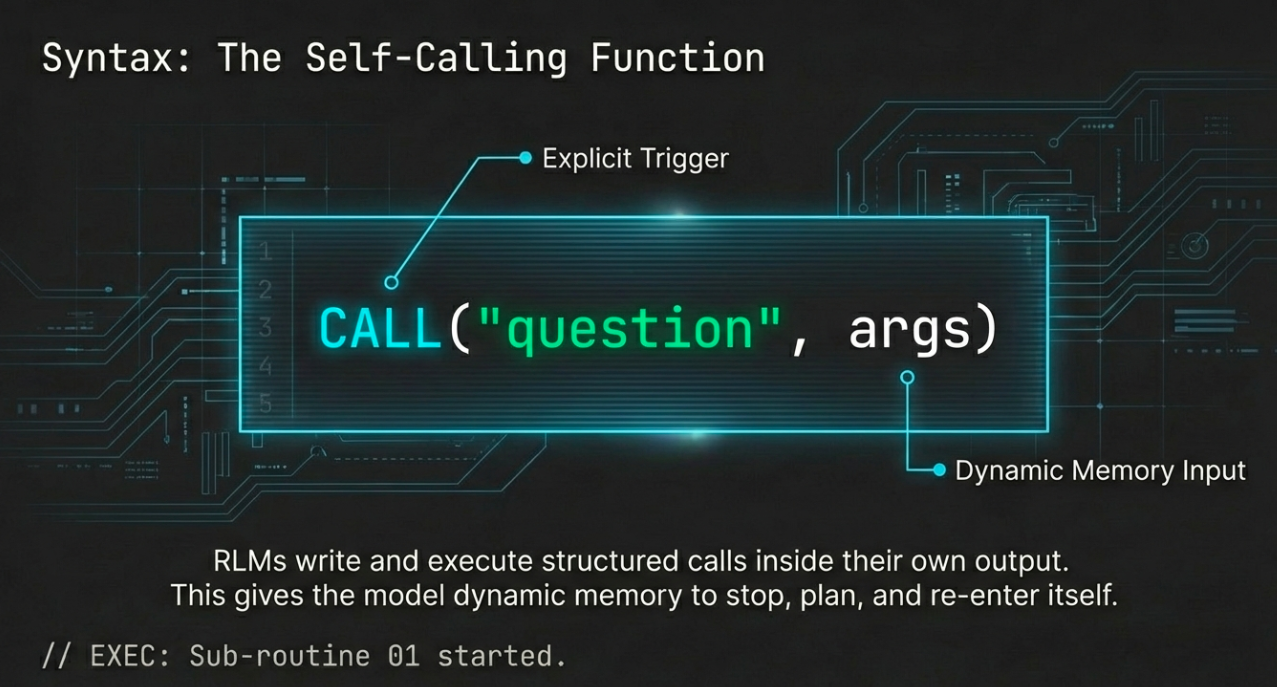

RLM은 한 번에 모든 것을 하려고 하지 않습니다. 그들은 구조화된 호출을 작성하고 실행합니다—예를 들어 CALL("question", args)와 같이—이를 자신의 출력 안에 삽입합니다. 시스템은 이 호출을 감지하고, 메인 응답을 일시 중지한 뒤 하위 작업을 평가하고, 결과를 삽입한 뒤 다시 진행합니다. 이것은 재귀적 루프이며, 모델이 플래너이자 실행자 역할을 동시에 수행합니다.

이 덕분에 RLM은 일종의 동적 메모리와 제어 흐름을 갖게 됩니다. 그들은 다음을 할 수 있습니다:

- 멈추고, 계획하고, 새로운 입력으로 자신을 다시 호출하기

- 여러 하위 작업의 결과를 결합하기

- 자신의 논리를 재사용하기

이것이 RLM을 강력하게 만들며, 오늘날 대부분의 모델이 사용하는 정적인 프롬프트 방식과 근본적으로 다른 점입니다.

Why standard LLMs struggle with multi‑step tasks

언어 모델은 똑똑하게 들리는 데는 능숙합니다. 하지만 작업이 서로 의존하는 여러 단계로 이루어져 있을 때, 표준 모델은 모든 것을 일직선으로 생성하기 때문에 종종 실패합니다.

- 추론 과정을 일시 중지하거나 모듈화할 내장된 방법이 없음

- 명시적인 구조가 없음—단지 하나의 긴 텍스트 스트림일 뿐

프롬프트 엔지니어링(예: “step‑by‑step 생각하기” 또는 “작업 과정을 보여라”)은 결과를 개선할 수 있지만, 모델이 실제로 작동하는 방식을 바꾸지는 못합니다. 모델은 여전히 한 세션 안에서 모든 것을 생성하고, 논리를 모듈화하거나 재사용할 내장 메커니즘이 없습니다.

What RLMs bring to the table

Recursive Language Models은 복잡한 작업을 프로그램처럼 취급합니다. 모델은 단순히 답을 내놓는 것이 아니라, 자신에게 호출하는 코드와 같은 구문을 작성합니다. 이러한 호출은 실시간으로 평가되고, 그 결과가 응답에 다시 반영됩니다.

Benefits

- 자신의 논리를 재사용

- 작업의 한 부분에 집중

- 더 깊거나 재귀적인 문제에 확장

다시 말해, RLM은 구조 문제를 해결합니다. 그들은 언어 생성에 조합성 및 제어 흐름을 도입합니다—대부분의 LLM이 아직 부족한 두 가지 요소입니다.

The core RLM loop

Generate → Detect → Call → Repeat

-

모델이 프롬프트를 받습니다.

-

응답을 생성하기 시작합니다.

-

하위 작업을 만나면 구조화된 함수 호출을 내보냅니다, 예:

CALL("Summarize", "text goes here") -

시스템이 일시 중지하고, 동일한 모델에 다시 입력하여 그 호출을 평가하고 결과를 얻습니다.

-

결과가 삽입되고, 원래 응답이 계속됩니다.

이 과정은 한 번도 일어날 수 있고, 하나의 응답 안에서 수십 번 반복될 수도 있습니다.

Concrete example

RLM에게 복잡한 기술 기사에 대한 설명을 요청한다고 가정해 보세요. 모델은 전체를 한 번에 요약하려 하지 않고, 다음과 같이 진행할 수 있습니다:

- 기사를 섹션별로 나눕니다.

- 각 섹션을 개별적으로 요약하기 위해 재귀 호출을 발행합니다.

- 그 조각들을 결합하여 최종 답변을 만듭니다.

What’s actually new?

- 모델이 단순히 텍스트를 생성하는 것이 아니라 실행을 제어합니다.

- 각 함수 호출은 명시적이며 기계가 읽을 수 있는 형태이며, 일반 텍스트에 숨겨져 있지 않습니다.

- 모델은 무엇을 말할지뿐 아니라 언제 하위 작업을 자신에게 위임할지를 학습합니다.

이 설계는 모듈식 추론을 도입합니다—프롬프트보다 프로그래밍에 더 가깝습니다. 이를 통해 RLM은 전통적인 LLM보다 더 길고, 더 깊으며, 더 조합적인 작업을 해결할 수 있습니다.

RLM과 추론 모델

재귀 언어 모델(Recursive Language Models)과 추론을 위해 설계된 모델을 혼동하기 쉽습니다. 두 모델 모두 더 어렵고 다단계 문제를 해결하려 하지만, 접근 방식은 매우 다릅니다.

| 측면 | 추론 모델 | 재귀 언어 모델 |

|---|---|---|

| 목표 | 고정된 응답 내에서 “더 잘 생각하기” | 모델이 실행되는 방식을 변경 |

| 메커니즘 | 프롬프트 트릭(“단계별로 생각해 보자”), 파인튜닝, 아키텍처 조정 | 구조화된 함수 호출, 실제 제어 흐름, 재귀 |

| 실행 | 한 번에 전체 출력을 생성 (평면, 선형) | 일시 중지하고, 하위 호출을 내보내며, 다시 진입하고, 결과를 점진적으로 구축 가능 |

| 투명성 | 내부 단계를 검사하기 어려움 | 각 재귀 호출이 명시적이며, 전체 연산 트리를 볼 수 있음 |

| 비유 | 더 나은 에세이 작성 | 프로그램을 작성하고 실행하기 |

추론 모델은 더 나은 에세이를 쓰려고 합니다. RLM은 프로그램을 작성하고 실행합니다.

RLM은 모든 하위 호출을 노출하기 때문에 검사와 디버깅이 더 쉬워집니다. 모델이 무엇을 물었고, 무엇을 답했으며, 결과를 어떻게 결합했는지 정확히 볼 수 있습니다—이는 일반적인 LLM 워크플로우에서는 드문 투명성 수준입니다.

더 큰 그림

- Reasoning models는 정적 프롬프트의 한계를 확장합니다.

- Recursive Language Models는 재정의합니다 모델이 런타임에 할 수 있는 것을.

재귀는 단순한 기술 업그레이드가 아니라, 언어 모델이 할 수 있는 것의 변화를 의미합니다. 재귀를 사용하면 모델은 한 번에 전체 답을 추측할 필요가 없습니다. 필요에 따라 자신의 능력을 재사용하면서 조각조각 구성할 수 있습니다. 이는 표준 모델이 어려워하는 새로운 행동을 가능하게 합니다.

Source: …

재귀 언어 모델(RLM) – 왜 중요한가

재귀가 다양한 작업에 도움이 되는 방법

- 논리 퍼즐 – 전체 해를 무차별 대입하는 대신, RLM은 각 규칙을 적고, 하위 경우들을 평가한 뒤 결과를 결합할 수 있습니다.

- 수학 서술형 문제 – 모델은 복잡한 문제를 단계로 나누고, 각 단계를 재귀적으로 해결하며 중간 답을 검증합니다.

- 코드 생성 – RLM은 함수를 초안으로 작성한 뒤, 스스로를 호출해 테스트 케이스를 만들거나 버그를 수정하거나 보조 함수를 생성할 수 있습니다.

- 증명 생성 – 정리 증명에서 재귀를 사용하면 모델이 증명 트리를 구축하고, 그 과정에서 작은 보조정리를 검증합니다.

실험 결과: 논문 실험에서 RLM은 다단계 벤치마크에서 비재귀 기반 모델보다 성능이 우수했으며 효율성도 높았습니다. 재귀 호출을 통해 모델이 논리를 재사용함으로써 전체 토큰 사용량을 줄일 수 있었습니다.

정확도 그 이상 – 효율성과 조합성

- 재귀는 단순히 정확도를 높이는 것이 아니라 효율성과 조합성을 향상시킵니다.

- 문제 규모에 따라 선형적으로 확장되는 대신, RLM은 작은 조각을 해결하고 해결책을 재사용함으로써 로그arithmically하게 확장할 수 있습니다.

- 이는 추론 깊이가 빠르게 증가하는 작업에 더 적합하게 만들며, 바로 LLM이 실제 응용에서 직면하기 시작한 문제 유형입니다.

현재 LLM 환경

대부분의 언어 모델은 여전히 간단한 패턴을 따릅니다:

Input → Output

이는 빠른 답변이나 가벼운 작업에는 적합하지만 복잡한 경우에는 한계가 있습니다.

오늘날 개발자들은 LLM 위에 에이전트, 체인, 도구 활용 시스템을 구축합니다. 이러한 래퍼는 구조를 흉내 내지만, 다음에 의존하기 때문에 종종 취약합니다:

- 프롬프트 해킹

- 정규식 파싱

- 외부 오케스트레이션

왜 RLM이 더 깔끔한 경로를 제공하는가

- 구성 요소 감소 – 외부 체인이나 맞춤 라우팅 로직이 필요 없으며, 모델이 언제 어떻게 분기할지 스스로 결정합니다.

- 투명성 향상 – 각 재귀 호출이 가시적이고 추적 가능해 단계별 감사를 할 수 있습니다.

- 일반화 향상 – 재귀 사용을 학습하면 모델은 수학, 코드, 추론, 계획 등 다양한 분야에 유연하게 적용할 수 있습니다.

앞으로의 전망

- RLM은 아직 초기 단계이지만, 모델을 단순 생성기가 아니라 런타임 환경으로 다루는 더 큰 변화를 예고합니다.

- 이는 모델이 스스로 계획하고, 행동하며, 적응할 수 있는