위대한 AI 융합: 2026년 PyTorch vs. TensorFlow

Source: Dev.to

인공지능이 급속히 진화하는 세상에서 두 거인, PyTorch와 TensorFlow가 여전히 풍경을 장악하고 있습니다. 수년간 개발자들은 어느 프레임워크가 더 우수한지 논쟁해 왔지만, 2025년을 지나면서 대화의 초점이 바뀌었습니다. 이제는 *“어느 것이 더 좋은가”*가 아니라 *“당신의 특정 워크플로에 어느 것이 맞는가”*가 핵심이 되었습니다.

당신이 생성 AI의 한계를 넓히는 연구자이든, 수백만 대의 엣지 디바이스에 모델을 배포하는 엔지니어이든, 이 프레임워크들의 미묘한 차이를 이해하는 것은 필수적입니다.

1. 핵심 철학 – 유연성 vs. 구조

| 항목 | PyTorch (동적) | TensorFlow (정적/하이브리드) |

|---|---|---|

| 출처 | Meta에서 개발 | Google에서 개발 |

| 계산 그래프 | Define‑by‑run – 코드가 실행되는 동안 그래프가 즉시 구축됩니다. 파이썬처럼 자연스럽고, 표준 루프, 조건문, 디버거(pdb)를 사용할 수 있습니다. | Define‑and‑run – 원래는 실행 전에 컴파일되는 정적 그래프였습니다. TensorFlow 2.x는 PyTorch와 같은 유연성을 위해 Eager Execution을 추가했지만, 핵심은 최적화된 정적 컴파일을 유지합니다. |

| 최적화 초점 | 실험 및 디버깅의 용이성 강조 | 하드웨어 수준의 공격적인 최적화 강조 (예: XLA, TPU 지원) |

2. Developer Experience & Debugging

-

PyTorch

- 현재 부드러운 Developer Experience (DX) 분야에서 왕관을 쓰고 있습니다.

- Python 생태계와 원활히 통합되며, 디버깅은 훈련 루프 안에

print()문이나 브레이크포인트를 삽입하는 것만큼 간단합니다. - 명확한 스택 트레이스로 문제 위치를 쉽게 찾을 수 있습니다.

-

TensorFlow

- Keras라는 고수준 API 덕분에 격차가 좁혀졌으며, 레고‑브릭 스타일로 레이어를 쌓아 빠르게 모델을 구축할 수 있습니다.

- under the hood에 들어가야 할 때(맞춤 손실 함수, 복잡한 그래디언트 계산 등) 오류 메시지는 PyTorch의 직관적인 트레이스에 비해 여전히 난해할 수 있습니다.

3. Production & Deployment – The Enterprise Edge

| Feature | PyTorch | TensorFlow |

|---|---|---|

| Enterprise‑grade tooling | TorchServe 로 모델 서빙, TorchScript 로 모델 직렬화, ONNX 지원을 통한 상호 운용성 제공. | TensorFlow Extended (TFX) 로 엔드‑투‑엔드 파이프라인 구축, TensorFlow Lite 로 모바일/IoT 지원, TensorFlow Serving 으로 버전 관리 및 롤링 업데이트가 가능한 확장 가능한 모델 서빙 제공. |

| Maturity for large‑scale deployments | 빠르게 개선 중이며, 많은 프로덕션 시나리오에 적합. | 오랜 기간 검증된, 대규모 글로벌 인프라에서 입증된 솔루션. |

| Ecosystem “batteries‑included” | 생태계가 성장하고 있지만 아직 TensorFlow 만큼 폭넓지는 않음. | 데이터 수집, 학습, 검증, 서빙, 모니터링까지 포괄하는 종합적인 스위트 제공. |

4. Performance – 2025 Benchmarks

-

PyTorch 2.0+

torch.compile()을 도입했으며, Triton 컴파일러를 활용합니다.- 한 줄의 코드만으로 30 %–60 % 정도의 속도 향상이 일반적입니다.

-

TensorFlow

- **XLA (Accelerated Linear Algebra)**를 사용해 연산을 결합하고 메모리 오버헤드를 줄입니다.

- 특히 Google TPU와 고처리량 추론 워크로드에서 효율적입니다.

General observation:

- PyTorch는 프로토타이핑 및 중소 규모 학습에서 약간 더 빠른 경향이 있습니다.

- TensorFlow는 대규모, 고처리량 추론 시나리오에서 종종 앞섭니다.

TL;DR

- PyTorch를 선택하세요 빠른 실험, 직관적인 디버깅, 파이썬‑우선 느낌을 중시한다면.

- TensorFlow를 선택하세요 대규모 프로덕션을 위한 견고한 도구와 성숙한 엔터프라이즈‑레디 생태계가 필요하고, 특히 모바일/IoT 또는 TPU 하드웨어를 목표로 할 때.

두 프레임워크는 유연성과 성능 면에서 크게 수렴했으므로, 이제 “올바른” 선택은 워크플로우의 구체적인 요구사항, 팀 전문성, 그리고 배포 대상에 달려 있습니다.

End‑to‑End ML Lifecycle Tools

- TensorFlow Extended (TFX) – 엔드‑투‑엔드 파이프라인을 관리하기 위한 플랫폼.

- TensorFlow Lite – 모바일(iOS/Android) 및 IoT 디바이스에 모델을 배포하기 위한 금본위 표준.

- TensorFlow Serving – 내장된 버전 관리와 롤링 업데이트 기능을 갖춘, 대규모 모델 배포를 위한 매우 성숙한 툴링.

PyTorch는 TorchServe, TorchScript, 그리고 ONNX(Open Neural Network Exchange) 포맷 지원을 통해 큰 진전을 이루었습니다. 하지만 전 세계 인프라에 수천 개의 모델을 배포해야 하는 기업 입장에서는 TensorFlow의 성숙도가 따라잡기 어렵습니다.

5. 성능: 2025 벤치마크 (재검토)

- **PyTorch 2.0+**는

torch.compile()을 도입했으며, Triton 컴파일러를 사용해 단 한 줄의 코드만으로도 **30 %–60 %**에 달하는 대규모 속도 향상을 제공합니다. - TensorFlow는 XLA를 활용해 연산을 결합하고 메모리 오버헤드를 줄여, 구글의 TPU에서 매우 효율적으로 동작합니다.

핵심 요약

- PyTorch는 프로토타이핑 및 소규모‑중간 규모 학습에서 약간 더 빠릅니다.

- TensorFlow는 대규모 프로덕션 워크로드에서 고처리량 추론에 있어 종종 앞서 있습니다.

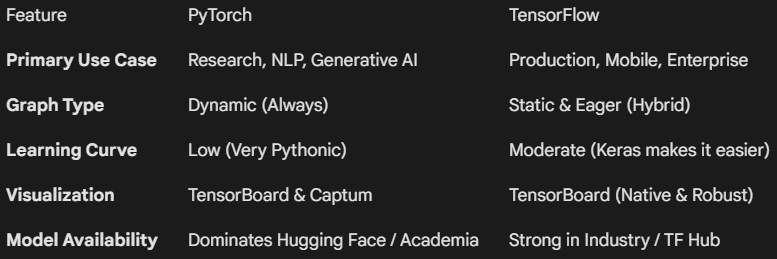

한눈에 보는 비교

6. Ecosystem and Community

- PyTorch – 학계에서 가장 사랑받는 프레임워크. arXiv에 발표되는 새로운 AI 논문의 약 90 %가 PyTorch를 사용하며, GPT‑4 변형이나 Stable Diffusion과 같은 최첨단 모델에 주로 쓰인다.

- TensorFlow – 기업에서 폭넓게 사용되는 프레임워크. Google Cloud Platform(GCP)과 깊이 통합되어 있으며, 안정성과 장기 지원이 실험적 기능보다 우선시되는 소매, 금융, 의료 등 대규모 산업에서 선호된다.

최종 결론: 어느 쪽을 선택해야 할까요?

“프레임워크 전쟁”은 이제 평화로운 교착 상태에 도달했습니다—두 도구 모두 훌륭하지만, 서로 다른 용도에 맞게 설계되었습니다.

- PyTorch를 선택해야 할 경우: 학생, 연구원, 혹은 스타트업 개발자이며, 빠르게 반복하고 맞춤형 아키텍처를 실험하고 싶고, Hugging Face에서 최신 오픈‑소스 모델에 접근하고 싶을 때.

- TensorFlow를 선택해야 할 경우: 대규모 프로덕션 환경에서 작업하고, 모델을 모바일/웹에 배포해야 하며, Google Cloud 생태계에 깊이 투자하고 있을 때.

프로 팁

2026년에는 가장 가치 있는 AI 엔지니어가 “이중 언어 구사자”입니다. 기본 개념(텐서, 역전파, 옵티마이저)은 동일하기 때문에, 하나의 프레임워크를 마스터하면 다른 프레임워크를 배우는 것이 훨씬 쉬워집니다.