활성화 함수: 단순한 곡선이 신경망에 힘을 실어주는 방법

Source: Dev.to

해당 텍스트가 제공되지 않았습니다. 번역을 원하시는 내용을 함께 알려주시면 도와드리겠습니다.

Source: …

Activation Functions – The Building Blocks of Neural Networks

이전 글에서 우리는 sequence‑to‑sequence 모델에 대해 간략히 언급하고 **RNN(순환 신경망)**을 소개했습니다.

RNN을 이해하려면 먼저 활성화 함수부터 시작해 신경망의 기본 개념을 알아야 합니다.

활성화 함수란?

신경망은 층(layer) 으로 구성되며, 각 층에는 많은 뉴런(neuron) 이 존재합니다. 뉴런 안에서는 두 가지 일이 일어납니다:

- 입력이 가중치와 결합됩니다.

- 그 결과가 활성화 함수를 통과합니다.

활성화 함수를 저울에 비유하면, 주어진 입력에 대해 뉴런이 얼마나 발화할지를 결정하는 역할을 합니다.

곡선으로 보는 활성화 함수

활성화 함수는 입력 값을 출력 값으로 변환하는 수학적 곡선입니다. 가장 흔히 다루는 함수는 다음과 같습니다:

- ReLU

- Softplus

- Sigmoid

아래에서는 작은 Python 스니펫(Numpy + Matplotlib)을 사용해 각 함수를 시각화해 보겠습니다.

import numpy as np

import matplotlib.pyplot as plt입력 값 생성

# -10부터 10까지 균등하게 400개 생성

x = np.linspace(-10, 10, 400)-10→ 범위 시작(가장 음수 입력)10→ 범위 끝(가장 양수 입력)400→ 포인트 수, 그래프를 부드럽게 만듦

x는 활성화 함수에 입력되는 값들을 의미합니다. 이 값들을 함수에 통과시켜(예: ReLU 또는 Sigmoid) 입력이 어떻게 출력으로 변환되는지 시각화할 수 있습니다.

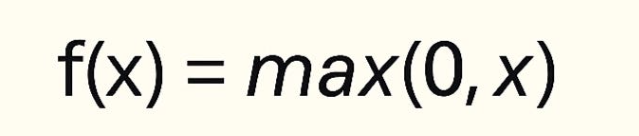

1. ReLU (Rectified Linear Unit)

- 입력이 음수이면 출력은 0이 됩니다.

- 입력이 양수이면 출력은 입력값과 동일합니다.

def relu(x):

return np.maximum(0, x)plt.figure()

plt.plot(x, relu(x), label="ReLU")

plt.title("ReLU Activation Function")

plt.xlabel("Input")

plt.ylabel("Output")

plt.grid(True)

plt.legend()

plt.show()

ReLU는 그 단순함과 효율성 때문에 대부분의 최신 신경망에서 기본 선택으로 사용됩니다.

2. Softplus (Smooth ReLU)

Softplus는 부드러운 버전의 ReLU입니다. ReLU가 0에서 급격히 꺾이는 반면, Softplus는 점진적으로 전환됩니다.

def softplus(x):

return np.log(1 + np.exp(x))plt.figure()

plt.plot(x, softplus(x), label="Softplus")

plt.title("Softplus Activation Function")

plt.xlabel("Input")

plt.ylabel("Output")

plt.grid(True)

plt.legend()

plt.show()

Softplus는 ReLU의 “죽은 뉴런(dead neuron)” 문제를 완화하지만, 계산 비용이 더 높아 실제 적용에서는 덜 사용됩니다.

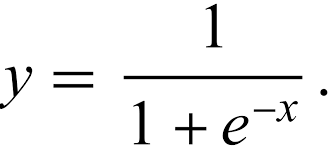

3. Sigmoid

Sigmoid는 모든 입력을 (0, 1) 구간으로 압축해 주므로, 이진 분류 출력에 유용합니다.

def sigmoid(x):

return 1 / (1 + np.exp(-x))plt.figure()

plt.plot(x, sigmoid(x), label="Sigmoid")

plt.title("Sigmoid Activation Function")

plt.xlabel("Input")

plt.ylabel("Output")

plt.grid(True)

plt.legend()

plt.show()

출력은 S자 형태의 곡선으로, 이진 분류에 이상적입니다.

Take‑away

- ReLU – 간단하고 빠르며, 은닉층의 기본 선택.

- Softplus – ReLU의 부드러운 버전으로, 급격한 경계점을 완화함.

- Sigmoid – 출력이 (0, 1) 구간에 제한돼 이진 분류에 적합.

ner 문제는 더 높은 계산 비용을 초래합니다.

- Sigmoid – (0, 1) 범위로 매핑되며, 이진 분류의 출력 레이어에 이상적이지만 깊은 네트워크에서는 기울기 소실 문제를 겪습니다.

이러한 활성화 함수를 이해하는 것은 RNN 및 시퀀스‑투‑시퀀스 모델과 같은 보다 복잡한 아키텍처를 마스터하기 위한 첫 번째 단계입니다. 코딩을 즐기세요!

예제는 Colab 노트북에서 직접 실행해 볼 수 있습니다.

활성화 함수가 네트워크에서 뉴런을 효율적으로 작동하게 하듯이, 올바른 도구를 갖추면 개발자로서의 작업이 훨씬 수월해집니다. 반복 작업, 익숙하지 않은 명령어, 디버깅 문제로 어려움을 겪어본 적이 있다면, 이 플랫폼이 여러분의 삶을 더 편하게 만들어 줄 것입니다. 이 플랫폼은 무료이며 오픈‑소스이고, 개발자를 위해 설계되었습니다.