JuiceFS+MinIO: Ariste AI, I/O 속도를 3배 빠르게 하고 스토리지 비용을 40% 이상 절감

발행: (2025년 12월 15일 오후 12:18 GMT+9)

6 min read

원문: Dev.to

Source: Dev.to

정량 투자에서의 스토리지 과제: 규모, 속도, 협업의 균형

정량 투자 프로세스는 데이터 레이어, 팩터·시그널 레이어, 전략·포지션 레이어, 실행·거래 레이어를 순차적으로 포함하며, 데이터 수집부터 거래 실행까지의 폐쇄 루프를 형성합니다.

주요 과제

- 데이터 규모 및 성장률 – 역사적 시장 데이터, 뉴스 데이터, 자체 계산 팩터 데이터가 총 500 TB에 육박하며, 매일 수백 기가바이트가 추가됩니다. 기존 디스크로는 이 요구를 충족시킬 수 없습니다.

- 고주파 접근 및 저지연 요구 – 저지연 읽기는 연구 효율에 직접적인 영향을 미치며, 읽기가 느려지면 비효율적인 연구가 발생합니다.

- 다중 팀 병렬 작업 및 데이터 관리 – 여러 팀이 동시에 실험을 수행할 때 데이터 혼동 및 유출을 방지하기 위해 독립적이고 안전한 격리가 필요합니다.

원하는 기능

- 고성능 – 단일 노드 읽기/쓰기 대역폭 > 500 MB/s; 접근 지연은 로컬 디스크 인지 임계값 이하.

- 쉬운 확장성 – 애플리케이션 변경 없이 스토리지와 컴퓨팅을 온디맨드로 수평 확장.

- 관리 역량 – 세분화된 권한 제어, 운영 감사, 데이터 수명 주기 정책을 하나의 화면에서 제공.

스토리지 아키텍처 진화

단계 1: 로컬 디스크

- QuantraByte 연구 프레임워크와 내장 ETF 모듈을 사용해 데이터를 로컬 디스크에 직접 저장.

- 장점: 빠른 읽기 속도, 빠른 반복 개발.

- 단점:

- 연구자 간 중복 다운로드 발생.

- 용량 제한(~15 TB)으로 성장에 부적합.

- 타인의 결과 재사용 시 협업 어려움.

단계 2: MinIO 중앙 관리

- 모든 데이터를 MinIO에 중앙 집중화하고, 별도 모듈이 데이터 수집을 담당.

- 이점: 공용 데이터 다운로드 통합, 다중 팀 공유를 위한 권한 격리, 스토리지 활용도 향상.

- 새로운 병목:

- 고주파 랜덤 읽기의 높은 지연.

- MinIO Community Edition에 캐시가 없어 고주파 데이터의 읽기/쓰기 속도가 느림.

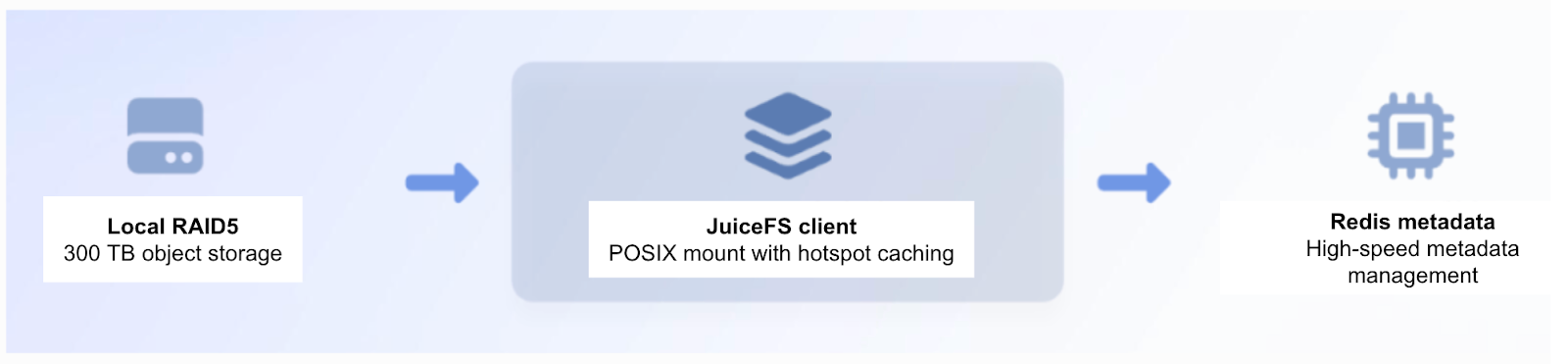

단계 3: JuiceFS 도입으로 캐시 가속

- 클라이언트 측 로컬 RAID5 스토리지를 활용한 JuiceFS 캐시 가속을 배포.

- 결과: 읽기/쓰기 성능이 약 3배 향상되어 고주파 공유 데이터 접근이 크게 개선됨.

- 데이터 양이 300 TB를 초과하면서 로컬 RAID5 스토리지 확장은 느리고 위험해졌으며, 수동 재구성이 필요해졌음.

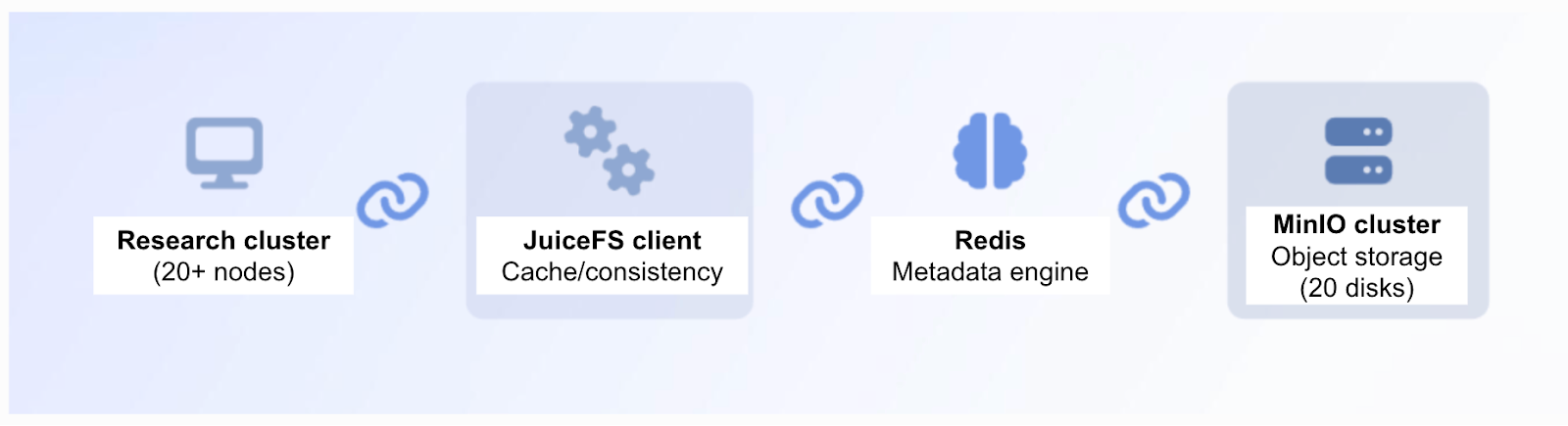

단계 4: JuiceFS + MinIO 클러스터

- JuiceFS와 MinIO를 결합한 클러스터형 아키텍처를 채택.

- 장점:

- 지속적인 고성능: JuiceFS 캐시가 고주파 접근 요구를 충족.

- 쉬운 클러스터 확장: 동일한 디스크를 추가해 용량을 유연하게 늘릴 수 있어 빠른 수평 확장이 가능.

이 네 단계의 진화를 통해 정량 워크로드에 적합한 캐시 가속, 탄력적인 객체 스토리지, 그리고 POSIX 호환성을 결합한 통합 솔루션의 실현 가능성을 검증했습니다. 이 접근 방식은 성능, 비용, 관리의 균형을 맞춘 재현 가능하고 구현 가능한 베스트 프랙티스 템플릿을 제공합니다.

성능 및 비용 효과

- JuiceFS + MinIO 아키텍처는 시스템 대역폭과 자원 활용 효율을 크게 향상시켜 연구 애플리케이션의 성능 요구를 완전히 충족했습니다.

- JuiceFS 캐시 레이어를 추가한 후 백테스팅 효율이 급증했습니다: 1억 건의 틱 데이터 테스트 시간이 몇 시간에서 수십 분으로 단축되었습니다.

- 전체 스토리지 비용은 ≈ 40 % 감소했으며, I/O 처리량은 ≈ 3배 증가했습니다.