Auto-grading 10년 된 Hacker News 토론을 뒤돌아보며

Source: Hacker News

개요

어제 나는 이 HN 스레드 — Show HN: Gemini Pro 3 hallucinates the HN front page 10 years from now — 를 우연히 발견했다. 여기서 Gemini 3이 10년 뒤의 프론트 페이지를 환각하고 있었다. 한 댓글이 정확히 10 년 전인 HN 프론트 페이지(2015‑12‑09)로 연결돼 있었다. 그 토론들을 읽으며 나는 LLM이 사람보다 훨씬 효율적으로 예지력을 평가할 수 있겠다는 생각이 들었다. 새로 출시된 Opus 4.5를 이용해 2015년 12월의 모든 HN 프론트‑페이지 글을 가져오고, ChatGPT 5.1 Thinking으로 사후 분석을 수행한 뒤, 결과를 정적 HTML로 렌더링하는 파이프라인을 만들었다.

레포지토리는 GitHub에 있다: .

왜 이 연습이 흥미로운가

미래 예측 모델 훈련

미래를 예측하는 것은 심각하고 학습 가능한 기술로 다룰 수 있다. 충분한 과거 데이터와 피드백 루프가 있다면 우리의 예측 능력을 향상시킬 수 있다—이는 “슈퍼포캐스터”들이 이미 주장하는 바이다.

미래 LLM이 우리를 지켜보고 있다

오늘 우리가 하는 모든 일은 미래에 저렴하게 실행 가능한 인공지능에 의해 상세히 검토될 수 있다. 완벽한 재구성과 합성이 가능해지면 “보안은 은폐에 있다”는 가정은 깨지기 쉽다. 지금 책임감 있게 행동하는 것이 좋다.

구현

데이터 수집

- 날짜를 주면 프론트 페이지(≈30개 기사)를 다운로드한다.

- 각 기사에 대해 Algolia API를 이용해 기사 내용과 전체 댓글 스레드를 가져온다.

- 분석을 위해 모든 것을 마크다운 프롬프트로 패키징한다.

ChatGPT 5.1 Thinking에 사용된 프롬프트

The following is an article that appeared on Hacker News 10 years ago, and the discussion thread.

Let's use our benefit of hindsight now in 6 sections:

1. Give a brief summary of the article and the discussion thread.

2. What ended up happening to this topic? (research the topic briefly and write a summary)

3. Give out awards for "Most prescient" and "Most wrong" comments, considering what happened.

4. Mention any other fun or notable aspects of the article or discussion.

5. Give out grades to specific people for their comments, considering what happened.

6. At the end, give a final score (from 0-10) for how interesting this article and its retrospect analysis was.

As for the format of Section 5, use the header "Final grades" and follow it with an unordered list in the format:

- name: grade (optional comment)

Example:

Final grades

- speckx: A+ (excellent predictions on …)

- tosh: A (correctly predicted this or that …)

- keepamovin: A

- bgwalter: D

- fsflover: F (completely wrong on …)

For Section 6, use the prefix:

Article hindsight analysis interestingness score: 처리 과정

- 프롬프트를 OpenAI API를 통해 GPT 5.1 Thinking에 제출한다.

- 반환된 마크다운을 파싱한다.

- 결과를 정적 HTML 페이지로 렌더링해 쉽게 탐색할 수 있게 만든다.

렌더링 및 호스팅

생성된 페이지는 에 호스팅된다.

모든 중간 데이터 파일은 동일한 URL 접두사 아래 data.zip 형태로 제공된다(직접 링크는 의도적으로 제외).

예시

2015년 12월의 하이라이트 페이지 몇 개:

- 2015 년 12 월 3 일 – Swift가 오픈소스가 되다

- 2015 년 12 월 6 일 – Figma 출시

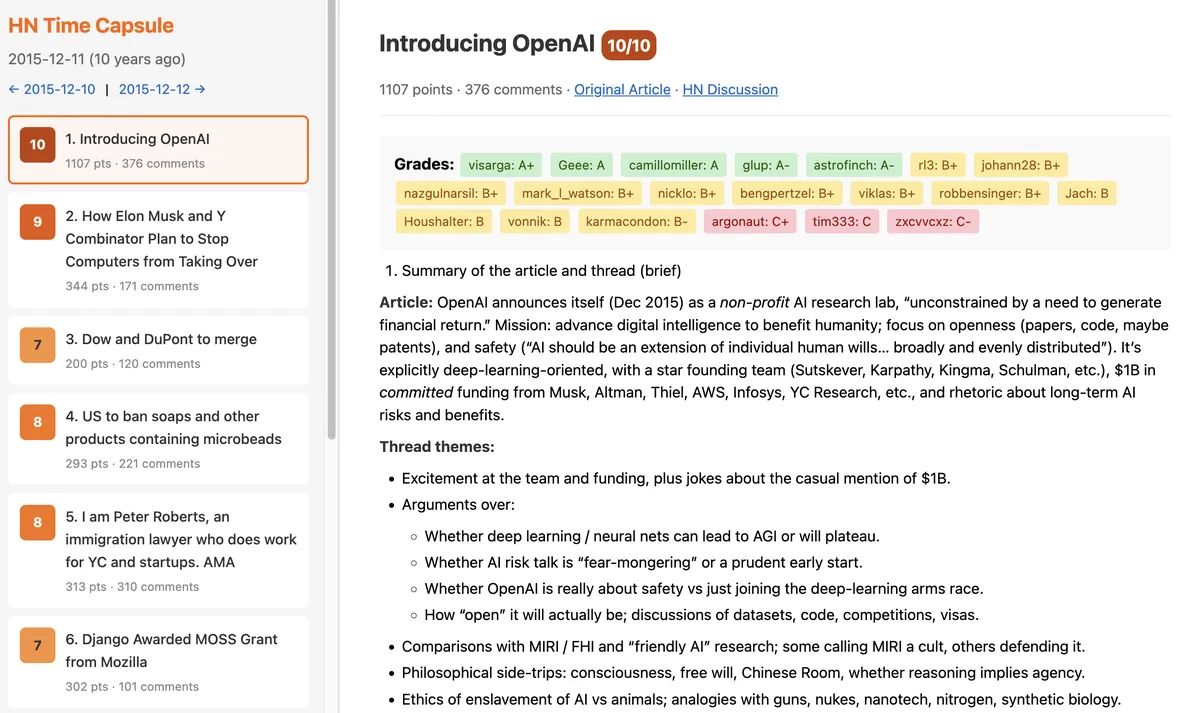

- 2015 년 12 월 11 일 – OpenAI 최초 발표

- 2015 년 12 월 16 일 – geohot이 Comma를 만든다

- 2015 년 12 월 22 일 – SpaceX 발사 웹캐스트: Orbcomm‑2 미션

- 2015 년 12 월 28 일 – Theranos 위기

명예의 전당

명예의 전당 페이지 ()는 2015년 12월의 상위 댓글 작성자를 IMDb‑스타일 평균 평점으로 순위 매긴다. 눈에 띄는 이름은 다음과 같다:

- pcwalton

- tptacek

- paulmd

- cstross

- greglindahl

- moxie

- hannob

- 0xcde4c3db

- Manishearth

- johncolanduoni

GPT 5.1 Thinking은 그들의 많은 댓글을 특히 통찰력 있고 예지력 있다고 표시했다.

비용 및 성능

31 일 × 30 기사 = 930 LLM 쿼리를 처리하는 데 약 $58가 들었고, 컴퓨팅 시간은 대략 1 시간 정도였다. 향후 모델은 이러한 사후 분석을 더욱 저렴하고 빠르게 만들 가능성이 크다.

결과를 탐험하는 사람들이 즐거워했으면 좋겠다. 코드(및 Opus 4.5 스크립트)는 오픈소스이므로 누구든지 분석을 재현하거나 확장할 수 있다.