为什么大多数 A/B 测试在订阅应用中失败

Source: Dev.to

如果你长期开发订阅类应用,迟早会遇到这样令人沮丧的时刻:

你进行了一次 A/B 测试。

你等了两周。

结果是……不确定。甚至更糟——误导性结论。

作为一名从事订阅产品的创始人和运营者,我多次目睹这种情况。团队投入时间进行 A/B 测试,却几乎看不到收入变化。信心下降,测试速度放慢。 最终,A/B 测试成了团队讨论的话题,而不是他们信任的工具。

在分析了数百个订阅应用和付费墙的迭代,并且自己犯了不少错误之后,我领悟到一个残酷的真相:

大多数 A/B 测试失败并不是因为执行不佳。

它们之所以失败,是因为从未被设计成回答正确的问题。

本文是我的 Weekly Growth Tactics 系列的第一篇。

让我们先从纠正对订阅应用中 A/B 测试的思考方式开始。

我早期的错误(许多团队仍在犯)

- 更改按钮颜色。

- 将价格调高。

- 添加折扣徽章。

等待转化率上升。

有时有效。很多时候无效。即使有效,我也无法自信地解释原因。

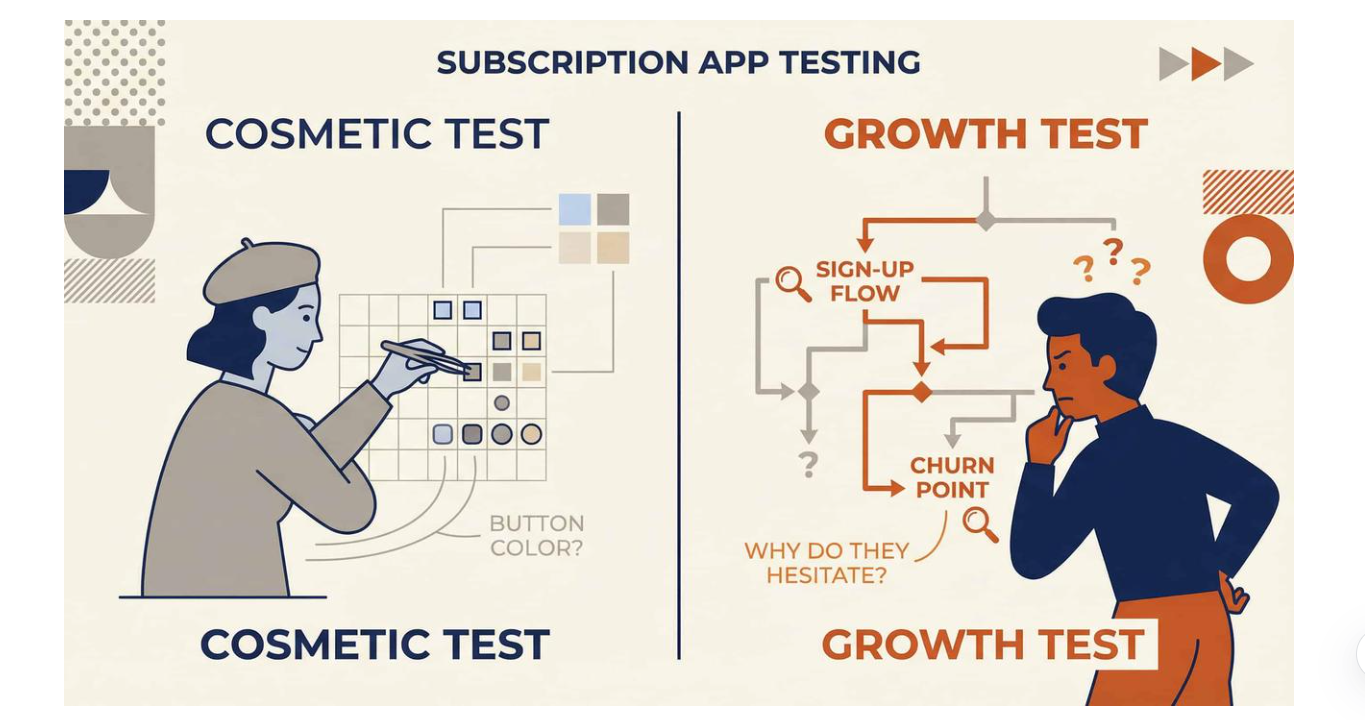

大多数订阅 A/B 测试是 表面实验,而非 增长实验。

它们优化的是像素——而不是决策。

为什么订阅 A/B 测试特别容易出错

Subscription products are fundamentally different from one‑time‑purchase apps. When users subscribe, they’re not just buying a feature—they’re committing to:

- Repeated payments

- Habit change

- Long‑term trust

This makes subscription funnels fragile in ways many teams underestimate.

订阅产品与一次性购买的应用根本不同。当用户订阅时,他们不仅仅是购买一个功能——他们还在承诺:

- 重复付款

- 习惯改变

- 长期信任

这使得订阅漏斗非常脆弱,许多团队往往低估了这一点。

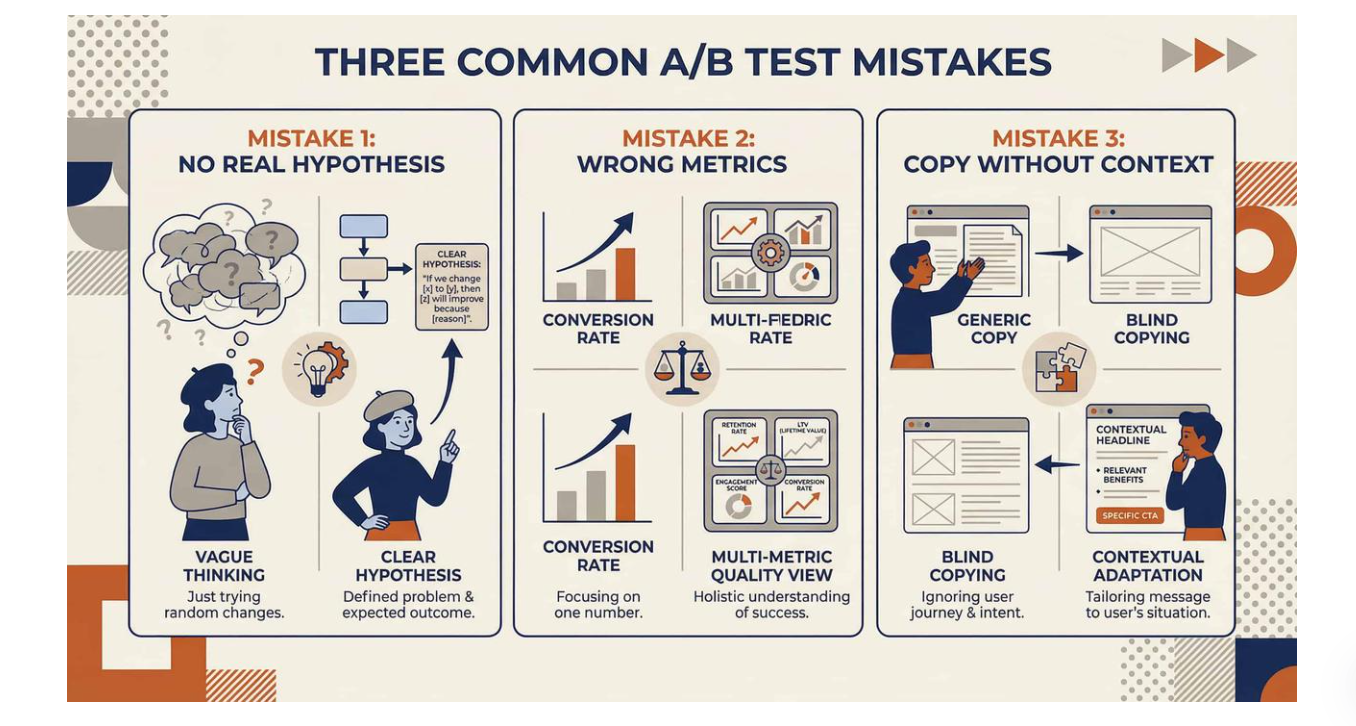

1. 团队在没有真实假设的情况下进行测试

Many tests start with:

“Let’s see if this converts better.”

That’s not a hypothesis. That’s curiosity.

A real hypothesis sounds like:

“If we show value before price, users who are unsure will feel safer starting a trial.”

Without this clarity, you can’t learn—only observe noise.

团队衡量错误的指标

Conversion rate alone is a trap. A paywall variant might:

- Increase trial starts

- Decrease paid retention

Resulting in lower ARPU after 30 days. Short‑term wins often hide long‑term losses. In subscription apps, revenue quality matters more than raw conversion.

仅仅看转化率是一个陷阱。付费墙的变体可能:

- 增加试用启动数

- 降低付费留存率

导致 30 天后的 ARPU 更低。短期的成功往往掩盖长期的损失。在订阅类应用中,收入质量比单纯的转化率更重要。

2. 团队在没有上下文的情况下盲目复制

This is extremely common.

You see a top app using:

- Annual plan default

- Aggressive urgency

- Emotional headlines

So you copy it.

What’s missing? Context:

- Country

- Traffic source

- Product maturity

- User intent

The same pattern can outperform in one app and completely fail in another.

这非常常见。

你看到一个顶级应用使用:

- 默认年度计划

- 强烈的紧迫感

- 情感化标题

于是你复制它。

缺少的是什么?上下文:

- 国家

- 流量来源

- 产品成熟度

- 用户意图

相同的模式在一个应用中可能表现出色,却在另一个应用中彻底失败。

Source: …

高绩效订阅团队的不同做法

在研究成功团队如何迭代付费墙、引导流程和定价后,出现了一个明显的模式:他们并不把 A/B 测试当作一种战术,而是把它视为一个 系统。

适用于订阅应用的更佳 A/B 测试框架

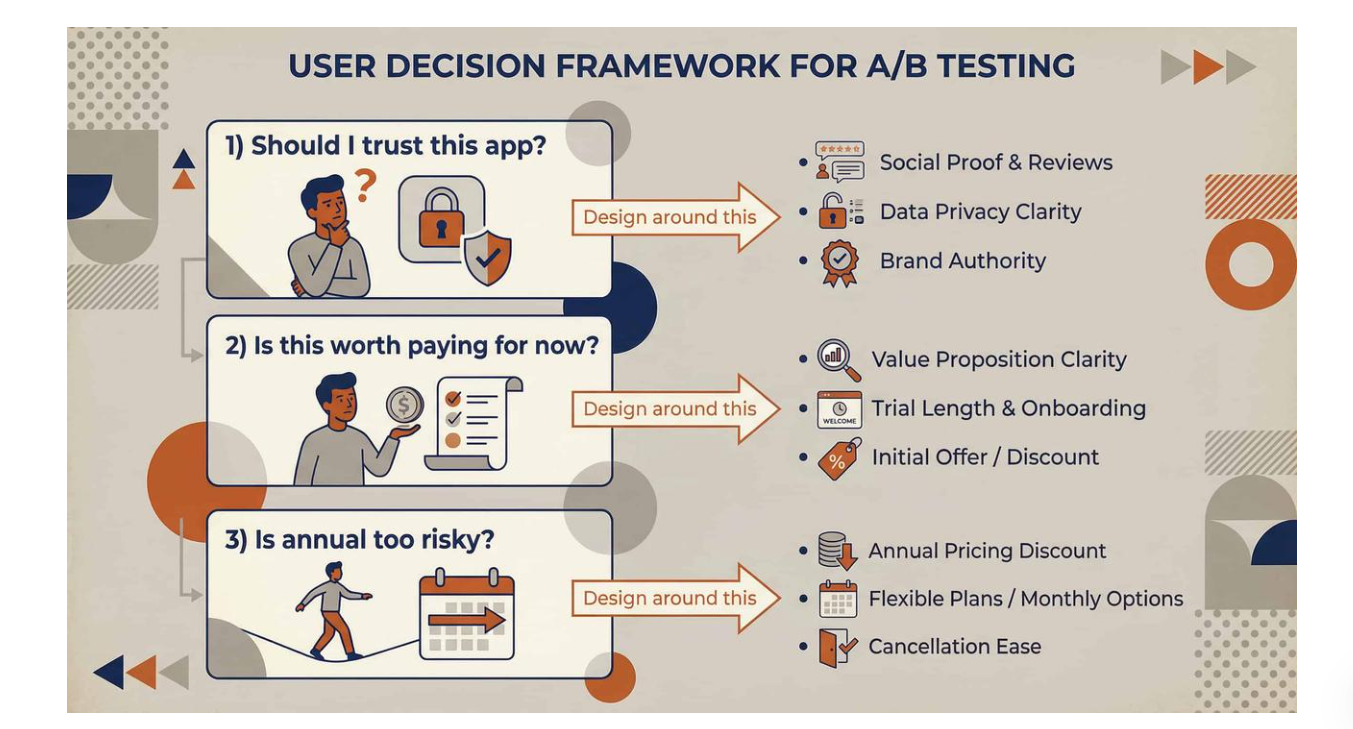

1. 从用户决策出发,而不是 UI

每一个有意义的 A/B 测试都应对应一个决策时刻:

- “我该信任这个应用吗?”

- “现在付费值得吗?”

- “年度订阅风险太大吗?”

不要问 “哪个布局转化率更高?”

要问 “是什么疑虑阻止用户做出承诺?”

围绕消除该疑虑来设计你的变体。

2. 测试更少的项目——但更深入

优秀的订阅团队不会进行 20 项浅尝辄止的测试。他们会进行更少的测试,聚焦于:

- 定价框架

- 价值传达

- 风险感知

- 承诺时机

一次精心设计的测试可以胜过十次随意的微调。

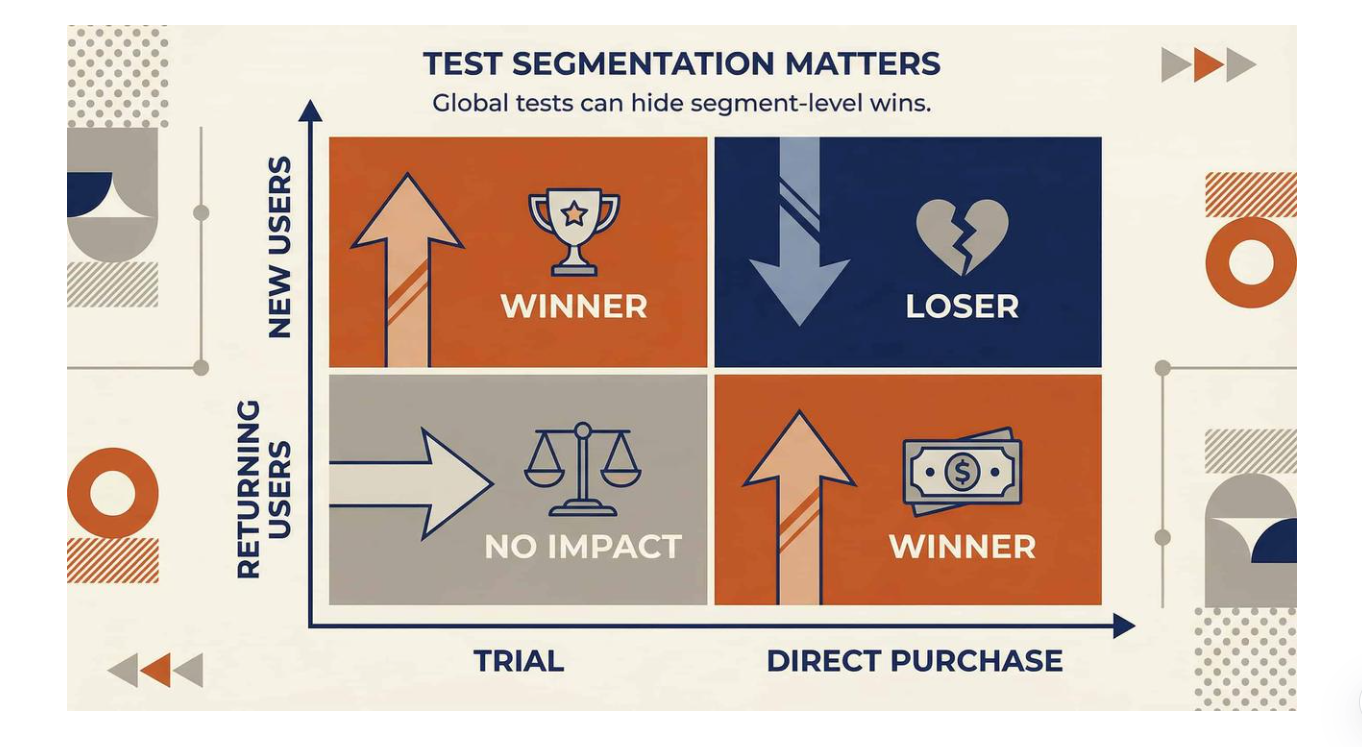

3. 在测试前先进行分群

没有分群的 A/B 测试是危险的。

至少要区分:

- 新用户 vs. 回访用户

- 试用用户 vs. 直接购买用户

- 高意向流量 vs. 低意向流量

在整体上“失利”的变体,可能在某一细分群体中表现极佳。

4. 接受部分测试只能给出方向性结论

并非每个测试都需要统计上的完美。某些测试的目的在于:

- 验证直觉

- 及早淘汰糟糕想法

- 缩小后续实验范围

等待完美的确定性往往会扼杀推进的动力。

糟糕 A/B 测试的隐藏成本

糟糕的测试不仅浪费时间。它们:

- 给团队传授错误的经验

- 降低对数据的信任

(继续阅读文章…)

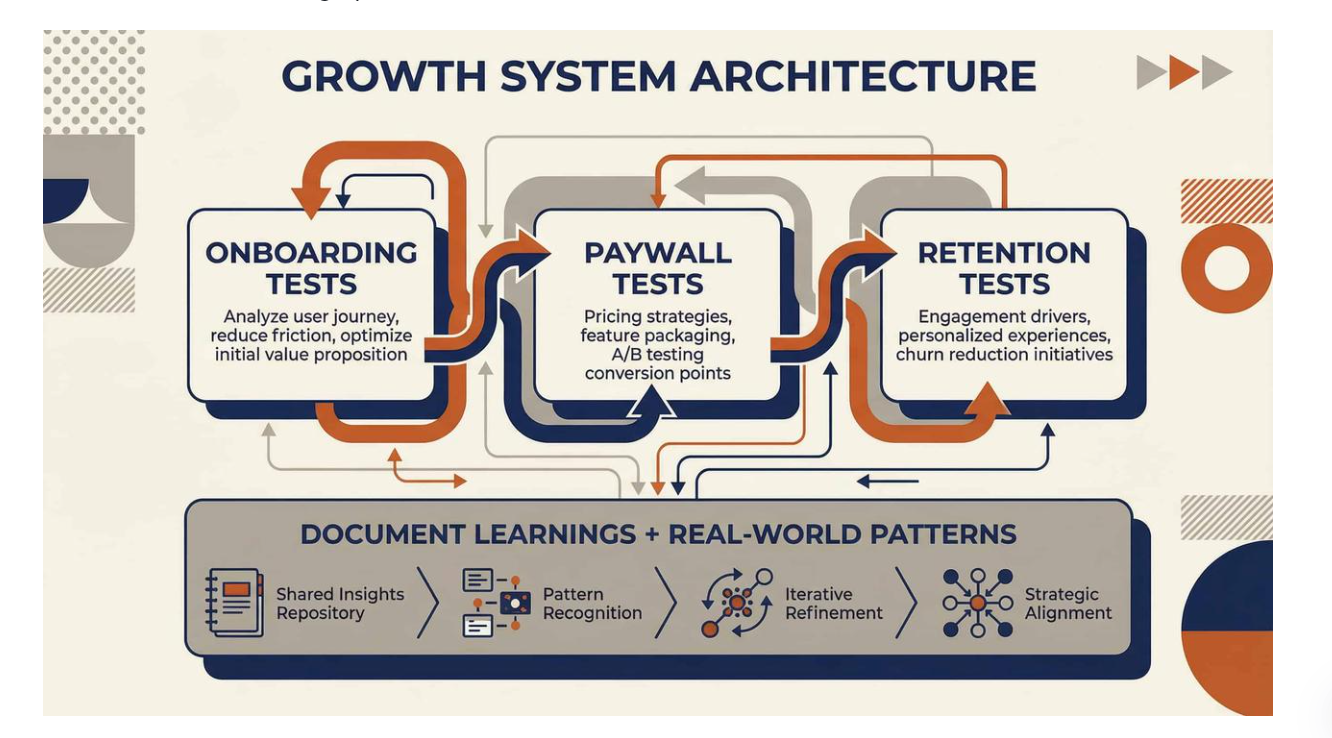

从孤立测试到增长系统

最佳的订阅团队始终坚持三件事:

- 记录学习,而不仅仅是结果

- 在 onboarding → paywall → retention 之间关联测试

- 研究真实世界的模式,而不仅仅是自己的应用

这正是行业级观察发挥威力的地方。通过分析数百个订阅应用随时间演进的付费墙和定价,你会看到:

- 真正推动收入的因素

- 仅在特定情境下有效的因素

- 大多数团队错误复制的内容

这些模式会在仪表盘完整呈现之前就显现出来。

最后思考:A/B 测试是手段,而非目标

A/B 测试无法拯救一个破碎的产品。

它也无法取代明确的价值。

它也不能修复薄弱的定位。

但如果做得正确,它会成为 指南针——而不是掷骰子。

如果你在构建订阅应用,请停止提问:

“我们接下来应该测试什么?”

开始提问:

“我们想改进的决策是什么?”

仅此转变就会改变你的结果。

想从真实的订阅实验中学习吗?

这些洞察来源于对数千个真实付费墙、引导流程和订阅应用定价变化的分析。

如果你想了解顶级应用如何实际测试、迭代并演进其变现策略,PaywallPro 为你提供真实世界的模式——而非猜测。

在 PaywallPro 上探索订阅应用的真实增长方式。

这仅是每周增长策略的开始。更多实验将在下周推出。