JuiceFS+MinIO:Ariste AI 实现 I/O 提速 3 倍,存储成本降低 40% 以上

发布: (2025年12月15日 GMT+8 11:18)

5 min read

原文: Dev.to

Source: Dev.to

量化投资中的存储挑战:在规模、速度与协作之间取得平衡

量化投资流程依次包括数据层、因子与信号层、策略与仓位层以及执行与交易层,形成从数据获取到交易执行的闭环。

关键挑战

- 数据规模与增长率 – 历史行情数据、新闻数据以及自算因子数据累计接近 500 TB,且每日新增数百 GB。传统硬盘无法满足此需求。

- 高频访问与低延迟要求 – 低延迟读取直接影响研究效率,读取慢则导致研究效率低下。

- 多团队并行与数据管理 – 需要独立且安全的隔离,以避免多团队同时实验时出现数据混淆和泄漏。

期望能力

- 高性能 – 单节点读写带宽 > 500 MB/s;访问延迟低于本地磁盘感知阈值。

- 易扩展 – 在不修改应用的前提下,实现存储和计算的按需横向扩容。

- 管理能力 – 细粒度权限控制、操作审计以及数据生命周期策略的统一视图。

存储架构的演进

阶段 1:本地磁盘

- 使用 QuantraByte 研究框架的内置 ETF 模块,将数据直接存储在本地磁盘上。

- 优点: 读取速度快,迭代迅速。

- 缺点:

- 研究人员之间重复下载。

- 容量受限(约 15 TB),难以支撑增长。

- 复用他人结果时协作困难。

阶段 2:MinIO 集中管理

- 将所有数据集中到 MinIO,另有模块负责数据接入。

- 收益: 统一公共数据下载,实现多团队共享的权限隔离,提高存储利用率。

- 新瓶颈:

- 高频随机读取延迟高。

- MinIO Community Edition 没有缓存,导致高频数据的读写慢。

阶段 3:引入 JuiceFS 进行缓存加速

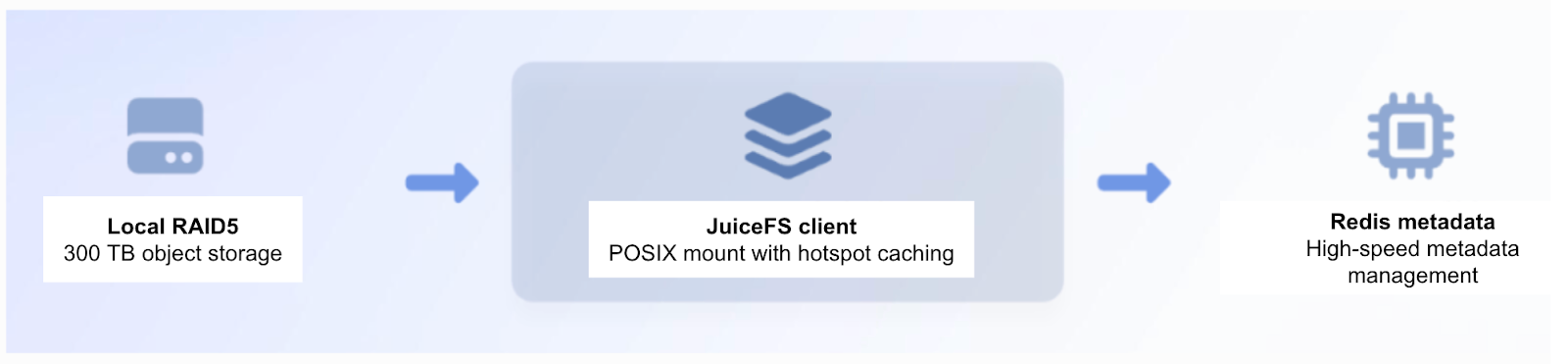

- 部署 JuiceFS 缓存加速,客户端使用本地 RAID5 存储。

- 结果: 读写性能提升约 3 倍,显著增强高频共享数据的访问速度。

- 当数据量突破 300 TB 后,扩展本地 RAID5 存储变得缓慢、风险高且需手动重新配置。

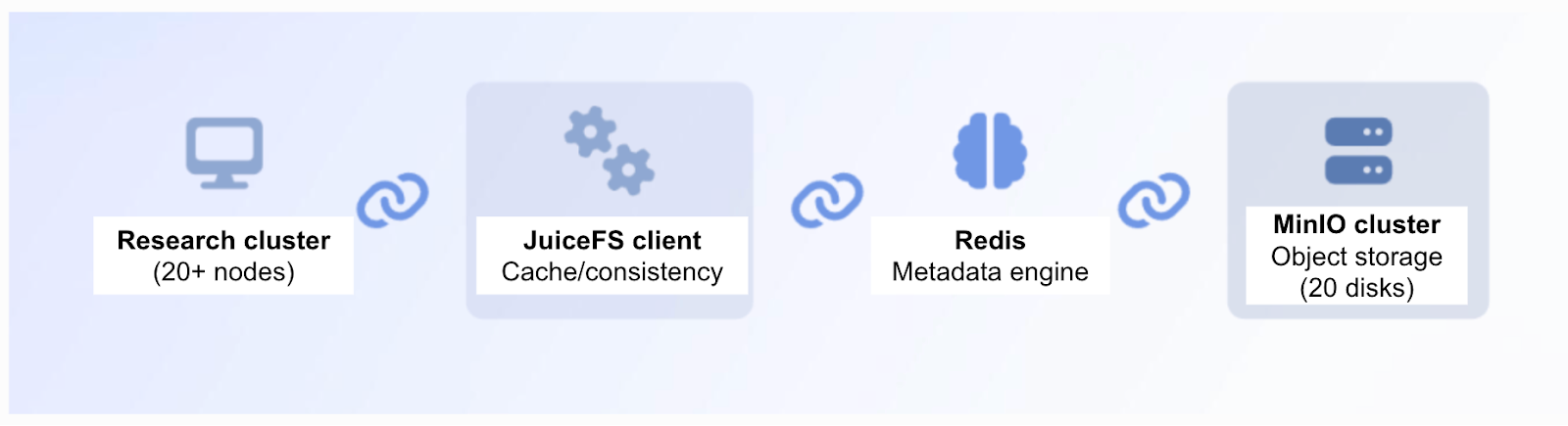

阶段 4:JuiceFS + MinIO 集群

- 采用 JuiceFS 与 MinIO 组合的集群架构。

- 优势:

- 持续高性能: JuiceFS 缓存满足高频访问需求。

- 集群易扩容: 通过添加相同规格的磁盘灵活提升容量,实现快速横向扩展。

通过这四个阶段的演进,我们验证了将缓存加速、弹性对象存储与POSIX兼容性相结合的整体解决方案在量化工作负载中的可行性。该方法提供了一个可复制、可实施的最佳实践模板,能够在性能、成本和管理之间取得平衡。

性能与成本收益

- JuiceFS + MinIO 架构显著提升了系统带宽和资源利用效率,完全满足了研究应用的性能需求。

- 添加 JuiceFS 缓存层后,回测效率大幅提升:对 1 亿条 tick‑data 条目的测试时间从数小时降至数十分钟。

- 整体存储成本降低约 40 %,而 I/O 吞吐量提升约 3 倍。