🚀 开发者如何停止假装懂 AI 热词

Source: Dev.to

“If you can’t explain it simply, you don’t understand it well enough.” — Albert Einstein

你有没有那种感觉:有人开始聊 具备 RAG 流程和向量嵌入的代理式 AI 工作流,大家都点头表示完全懂了?那时的我就是那个开发者——假装懂,却完全迷失。

几个月前,我到了崩溃的临界点。每个开发者讨论串、每场技术演讲都成了只剩噱头的词汇大杂烩,毫无实际清晰度。于是我不再装懂,决定真正去学习这些东西。情节反转:大多数人也在装懂。

研究论文的兔子洞

我的第一步?潜入 IBM 的研究论文。它们写得很严谨、研究充分,但也非常密集——我读完一篇后大脑就炸了。

下一站:YouTube。那儿有精彩的内容,但在看完一段关于 transformer 的视频、另一段关于嵌入的视频,再听到随意提到的“注意力机制”后,我仍然不知道它们之间的关联。

我一直在想:“能不能请有人给我一张干净的全图?把所有内容一次性放在一个地方,真正有逻辑?”

于是……我画了一张。

关键要点

- 对常常显得过于晦涩或“只限专家”的 AI 术语进行通俗阐释。

- 基础概念如何相互关联——模型、提示、安全性以及支撑 AI 堆栈的层级。

- 为什么提示很重要、它们何时会出错,以及如何让它们保持正轨。

- 机器如何学习、检索信息并生成更好的答案。

- 从简单聊天系统到工具、任务,再到能够代表你行动的完整 AI 助手的流程。

- 能够阅读 AI 讨论串、帖子、论文或视频而不感到迷失或精疲力尽。

准备好纸和笔,记笔记,按自己的节奏吸收。不要急。

开始之前

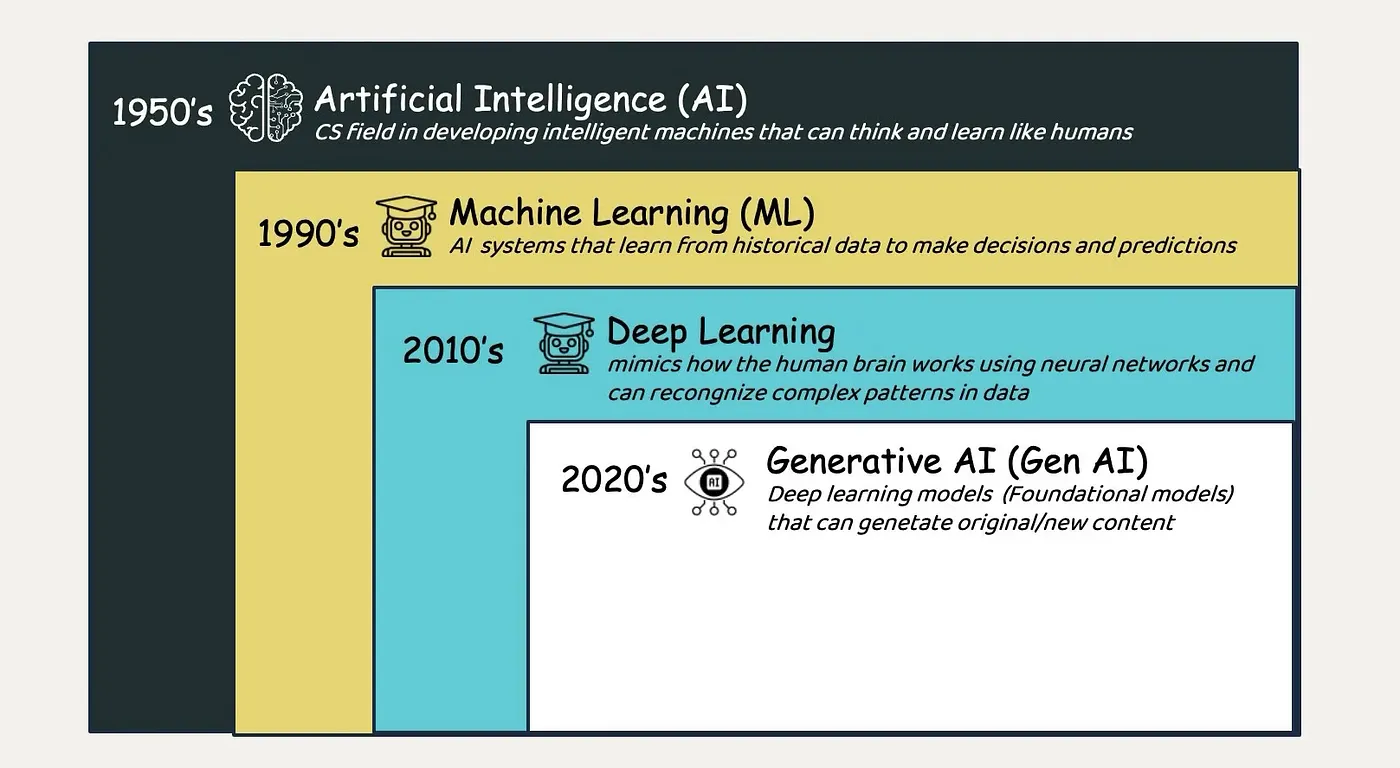

如果你是完全的新手,请先了解以下概念:

核心概念

- 神经网络 – 受大脑启发的、由相互连接的节点组成的结构,用于处理信息。

- 深度学习 – 通过堆叠大量神经网络层,从大规模数据集中学习复杂模式。

- 自然语言处理 (NLP) – 教会计算机理解、解释和生成人类语言。

- 机器学习 – 更广义的领域,计算机在不需要为每种情形显式编程的情况下,从数据中学习模式。

- 训练数据 – 用于教会 AI 模型识别模式和关系的示例集合。

- 模型 – 经过训练后能够进行预测或生成输出的 AI 系统。

- 算法 – 指导模型如何从数据中学习的数学规则。

- 模式识别 – AI 识别数据中重复结构、关系和趋势的能力。

- 预测 – 训练好的模型利用已学到的模式猜测下一步并生成输出。

- 推理 – 使用已训练的模型在新、未见过的数据上生成输出或做出决策。

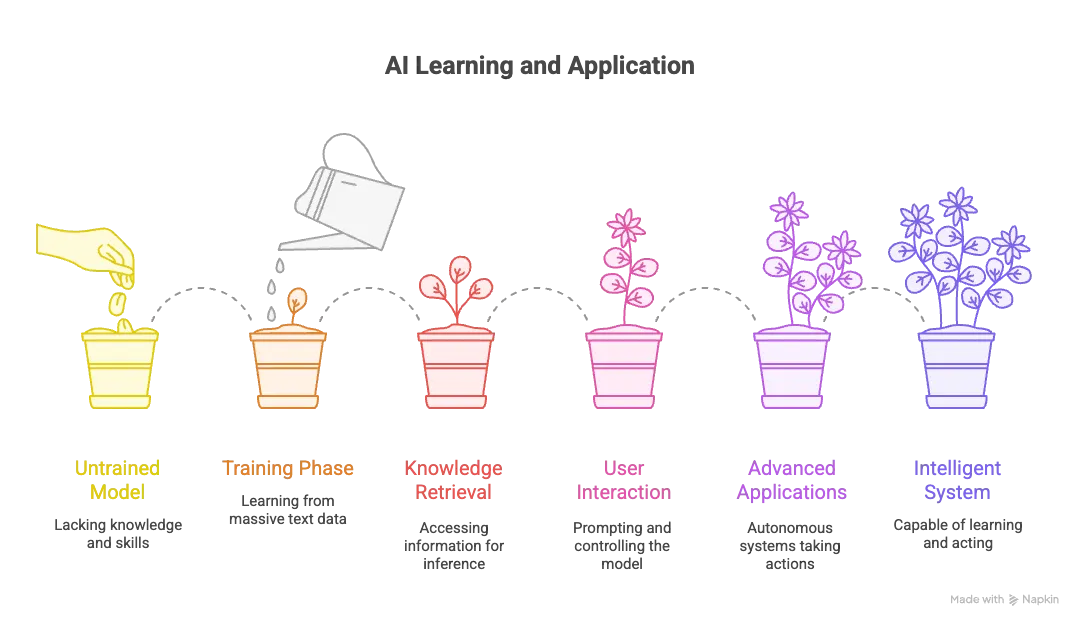

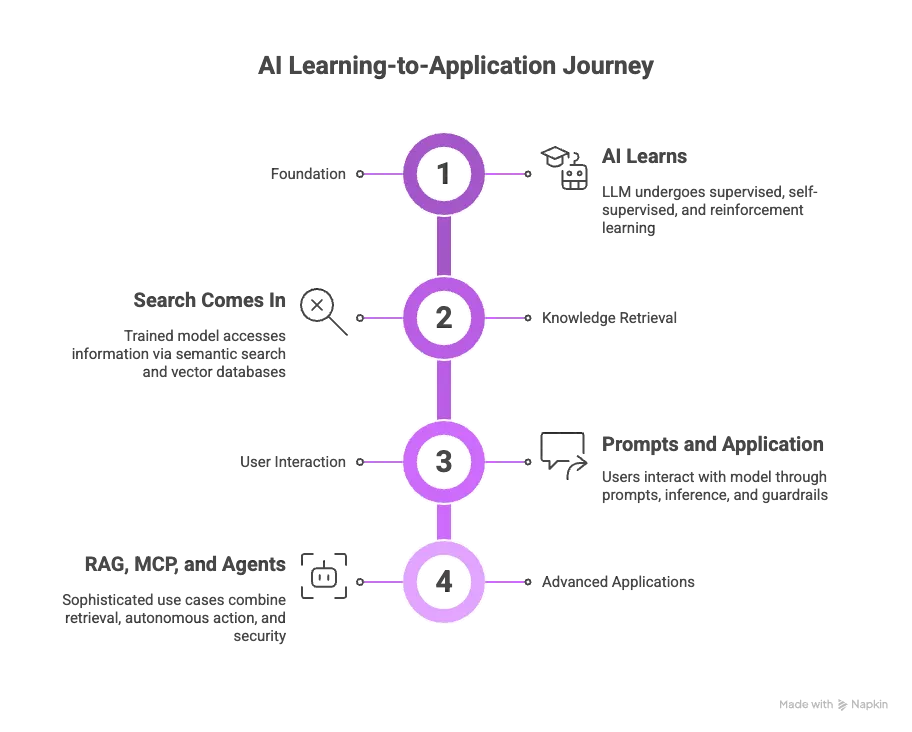

四阶段旅程

四阶段学习框架

与其在术语海洋里溺水,不如看看 AI 概念是如何实际关联的。

🎯 阶段 1:基础——AI 如何学习

大语言模型(LLM)必须先通过训练学习,这一过程主要有三种基本方式:

- 监督学习 – 从带标签的示例中学习。

- 自监督学习 – 在无标签数据中预测缺失部分(现代 LLM 的训练方式)。

- 强化学习 – 通过试错并获得反馈进行学习。

训练流水线

训练期间,模型会处理海量文本,步骤如下:

- 将文本拆分为 标记(tokens)。

- 将标记转换为 嵌入(embeddings)。

- 使用 注意力机制 判断哪些部分最重要。

- 在 Transformer 层 中构建捕捉复杂关系的模式。

为了让模型能够投入生产,我们会进行:

- 蒸馏 – 将大型模型压缩为更小、更快的版本。

- 量化 – 降低数值精度(例如从 32 位降到 8 位或 4 位),以在受限硬件上实现更快推理。

🔍 阶段 2:知识检索——连接训练与实时访问

模型训练完毕后,需要在推理时高效获取信息。这时 语义搜索 和 向量数据库 就变得至关重要。

语义搜索的工作原理

不同于传统的关键词匹配,语义搜索理解“意义”:

- 搜索 “smartphone” 同时会返回 “cellphone” 与 “mobile devices”。

- 相关概念在向量空间中彼此靠近。

向量数据库

向量数据库将数据存储为高维数值数组,实现闪电般的相似度搜索,这对实时 AI 应用至关重要。检索能力把模型在训练期间学到的知识与它在回答问题时能够访问的信息桥接起来。

💬 阶段 3:用户交互——提示、安全与推理

提示是与 AI 沟通的接口。当你提交提示时,模型会:

- 标记化 输入。

- 转换 标记为嵌入。

- 逐标记生成 响应(通过推理)。

- 计算 下一个标记的概率分布。

- 输出 概率最高的标记。

提示工程技术

- 零样本(Zero‑shot) – 不提供示例。

- 少样本(Few‑shot) – 提供少量示例输出。

- 链式思考(Chain‑of‑thought) – 步骤式推理。

安全考量

提示会带来风险:

- 幻觉(Hallucinations) – 生成的答案并未基于训练数据,属于捏造。

- 提示注入(Prompt injection) – 恶意指令伪装成用户输入。

因此 防护栏(guardrails)——跨数据、模型、应用和工作流的安全保障——对于保持 AI 系统的安全可靠至关重要。