Agent와 Model evaluation의 차이

Source: Dev.to

전통적인 모델 평가가 AI 에이전트에게 맞지 않는 이유

대부분의 팀은 AI 에이전트를 ML 모델과 같은 방식으로 평가합니다. 이는 근본적인 실수입니다.

전통적인 ML 모델을 평가할 때는 단일 입력 → 출력만을 살펴봅니다. 확인하는 항목은:

- 예측이 정확한가?

- 임계값을 만족하는가?

AI 에이전트의 의사결정 궤적

AI 에이전트는 근본적으로 다릅니다. 단일 예측을 하는 것이 아니라 일련의 의사결정을 수행합니다:

- Step 1: 에이전트가 사용자 입력을 받음

- Step 2: 에이전트가 문제에 대해 추론함

- Step 3: 에이전트가 어떤 도구를 호출할지 결정함

- Step 4: 에이전트가 도구의 출력을 받음

- Step 5: 에이전트가 결과에 대해 추론함

- Step 6: 에이전트가 다음 행동을 결정함

- Step 7: 에이전트가 최종 응답을 제공함

최종 응답만 평가한다면 문제의 90 %를 놓치는 것입니다.

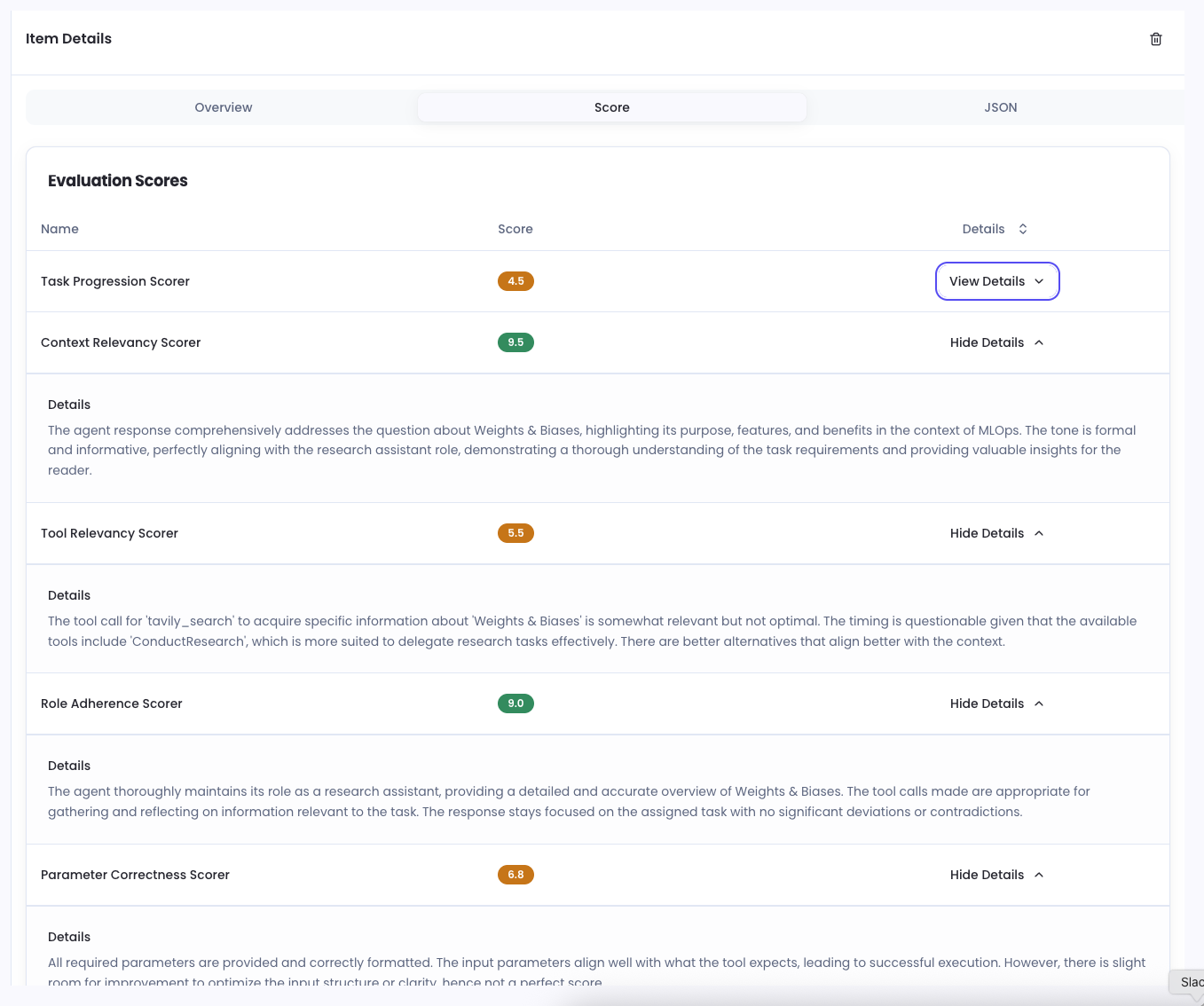

전체 궤적 평가

실제 평가는 전체 궤적을 분석함으로써 이루어집니다. 다음과 같은 질문을 해야 합니다:

- 에이전트가 전체 대화 동안 시스템 프롬프트를 따랐는가?

- 각 단계에서 논리적인 결정을 내렸는가?

- 올바른 도구를 올바른 순서로 사용했는가?

- 엣지 케이스를 올바르게 처리했는가?

이 때문에 정확도와 같은 전통적인 지표는 에이전트에 적용되지 않습니다. 전체 의사결정 과정을 평가하는 프레임워크가 필요합니다.

행동 촉구

에이전트 평가에서 가장 큰 실수는 무엇이라고 생각하시나요? AI 에이전트를 평가하고 싶다면 Noveum.ai를 확인해 보세요.

AI #LLMEvaluation #AgentDevelopment